Obtención de bloques IP y tasa liLos errores al extraer datos pueden arruinar tus proyectos rápidamente. Las listas de proxies gratuitos fallan en cuestión de horas y el código de rotación manual se convierte en un desastre. Creación de un web scraper en Python Para que esto permanezca indetectado, se requieren proxies rotativos que actúen como usuarios reales.

Los proxies residenciales solucionan esto cambiando las IPs automáticamente, eludiendo los sistemas anti-bot sin necesidad de código adicional.

Te mostraremos cómo configurar la rotación de proxies usando Decodo, convirtiendo tu programa de extracción de datos en una imparable máquina de recopilación de datos.

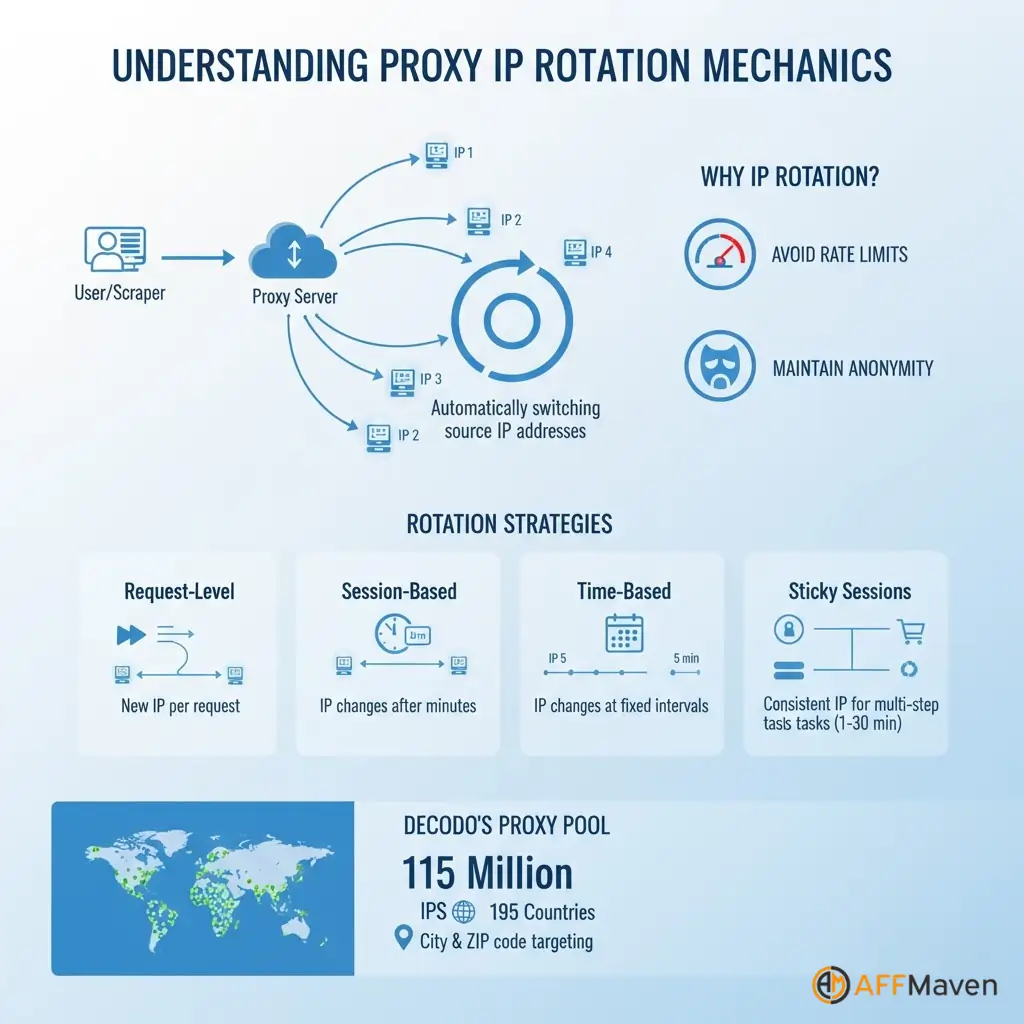

Comprensión de la mecánica de rotación proxy

La rotación de IP consiste en cambiar automáticamente la dirección IP de origen para cada solicitud o después de intervalos predefinidos. Esta técnica distribuye la carga de web scraping entre varias direcciones, evitando que una sola IP active los límites de frecuencia.

Las diferentes estrategias de rotación satisfacen diferentes necesidades:

Las sesiones persistentes mantienen una dirección IP activa temporalmente para procesos de varios pasos, como iniciar sesión en cuentas o completar transacciones.

Decodo Admite sesiones persistentes con una duración de entre uno y 30 minutos, lo que le brinda flexibilidad para flujos de trabajo complejos.

El concepto de pool de proxies proporciona acceso a millones de IP residenciales de dispositivos reales de todo el mundo. Decodo Mantiene un grupo de 115 millones de direcciones IP que abarca 195 países con una segmentación granular hasta el nivel de ciudad y código postal.

¿Por qué la rotación manual crea Problemas

Implementar manualmente la lógica de rotación parece sencillo, pero genera verdaderos quebraderos de cabeza en cuanto al mantenimiento. Necesitas proxy de origen Las listas se actualizan constantemente, ya que los proxies gratuitos caducan rápidamente. Probar cada proxy antes de usarlo añade latencia a cada solicitud.

Las listas de proxies gratuitos presentan serios problemas:

La rotación manual requiere código personalizado para seleccionar proxies, detectar fallos, eliminar direcciones IP inactivas y reintentar solicitudes. Este trabajo de infraestructura desvía la atención de las tareas reales. la extracción de datos tareas.

Rotación inteligente con Decodo Proxies residenciales

Decodo Simplifica todo con la gestión grupos de servidores proxy Contiene 115 millones de direcciones IP residenciales mantenidas automáticamente en 195 ubicaciones.

El servicio proporciona rotación automática integrada en el punto final del proxy, supervisión del estado que elimina las IP inactivas y segmentación geográfica por país, ciudad o Código postal precisión de nivel.

| Característica | Rotación manual | Decodo Solución: |

|---|---|---|

| Tamaño del grupo de IP | Limitado, inestable | Más de 115 millones de IP residenciales |

| Mantenimiento | Se requieren actualizaciones manuales | Monitoreo automático de la salud |

| Tasa de éxito | Variable, a menudo baja | tasa de éxito 99.86% |

| Geo localización | No disponible | País, ciudad, código postal, ASN |

| Tiempo de configuración | Horas de configuración | Minutos con API |

Regístrate para obtener un Decodo , y diríjase al panel de control del proxy. Copie su nombre de usuario, contraseña, punto de conexión y puerto de la sección de credenciales.

pip install requests beautifulsoup4 lxmlimport requests

from bs4 import BeautifulSoup

import random

# Decodo rotating residential proxy configuration

DECODO_HOST = 'gate.decodo.com'

DECODO_PORT = 7000

DECODO_USERNAME = 'your_username'

DECODO_PASSWORD = 'your_password'

# Create session ID for sticky sessions

session_id = random.randint(1000, 9999)

# Format proxy URL with session management

proxy_url = f'http://{DECODO_USERNAME}-session-{session_id}:{DECODO_PASSWORD}@{DECODO_HOST}:{DECODO_PORT}'

proxies = {

'http': proxy_url,

'https': proxy_url

}

def scrape_with_rotating_proxy(url):

"""Scrape URL using Decodo rotating residential proxy"""

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36'

}

try:

response = requests.get(url, proxies=proxies, headers=headers, timeout=30)

response.raise_for_status()

soup = BeautifulSoup(response.content, 'lxml')

return soup

except requests.exceptions.RequestException as e:

print(f"Error scraping {url}: {e}")

return None

# Scrape multiple URLs with automatic rotation

urls_to_scrape = [

'https://example.com/page1',

'https://example.com/page2',

'https://example.com/page3'

]

for url in urls_to_scrape:

data = scrape_with_rotating_proxy(url)

# Process extracted dataDecodo Gestiona la rotación de IP automáticamente. con cada nuevo ID de sesión, eliminando la lógica manual.

Las solicitudes de segmentación geográfica enrutan a través de países o ciudades específicas:

# Route through US residential IPs only

proxy_url = f'http://{DECODO_USERNAME}-country-us:{DECODO_PASSWORD}@{DECODO_HOST}:{DECODO_PORT}'

# City-level targeting

proxy_url = f'http://{DECODO_USERNAME}-city-newyork:{DECODO_PASSWORD}@{DECODO_HOST}:{DECODO_PORT}'La gestión de sesiones persistentes mantiene la misma IP en múltiples solicitudes:

# Use same proxy for 10 to 20 requests before generating new session

session_id = random.randint(1000, 9999)

proxy_url = f'http://{DECODO_USERNAME}-session-{session_id}:{DECODO_PASSWORD}@{DECODO_HOST}:{DECODO_PORT}'La rotación a nivel de solicitud genera la máxima diversidad de IP:

def get_fresh_proxy():

session_id = random.randint(1000, 99999)

return f'http://{DECODO_USERNAME}-session-{session_id}:{DECODO_PASSWORD}@{DECODO_HOST}:{DECODO_PORT}'import time

from requests.adapters import HTTPAdapter

from urllib3.util.retry import Retry

def create_session_with_retries():

"""Create requests session with automatic retries"""

session = requests.Session()

retry_strategy = Retry(

total=3,

backoff_factor=1,

status_forcelist=[429, 500, 502, 503, 504]

)

adapter = HTTPAdapter(max_retries=retry_strategy)

session.mount("http://", adapter)

session.mount("https://", adapter)

return session

def robust_scrape(url, max_retries=3):

"""Scrape with automatic proxy rotation and error handling"""

session = create_session_with_retries()

for attempt in range(max_retries):

session_id = random.randint(1000, 99999)

proxy_url = f'http://{DECODO_USERNAME}-session-{session_id}:{DECODO_PASSWORD}@{DECODO_HOST}:{DECODO_PORT}'

proxies = {'http': proxy_url, 'https': proxy_url}

try:

response = session.get(url, proxies=proxies, timeout=30)

if response.status_code == 200:

return BeautifulSoup(response.content, 'lxml')

else:

print(f"Status {response.status_code} on attempt {attempt + 1}")

time.sleep(2 ** attempt)

except Exception as e:

print(f"Attempt {attempt + 1} failed: {e}")

time.sleep(2 ** attempt)

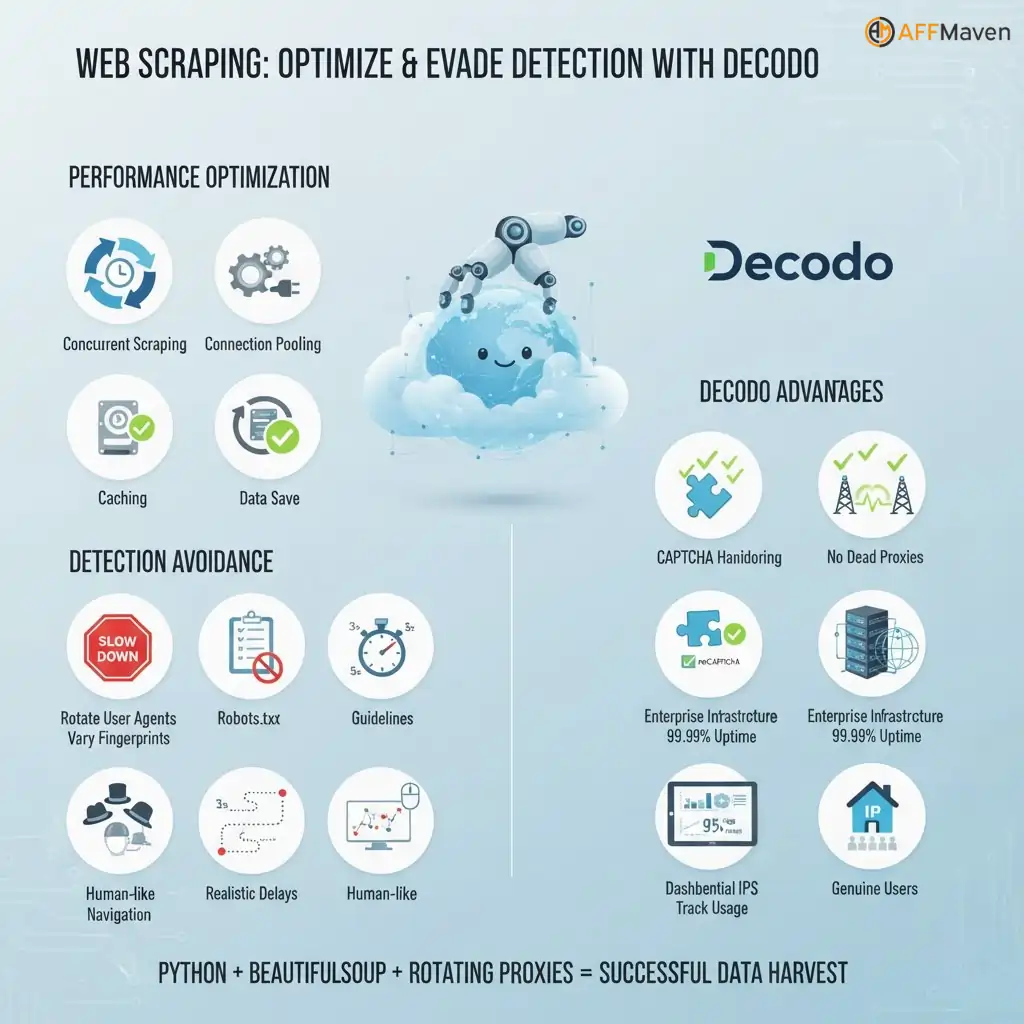

return NoneOptimización y mejores prácticas

Optimización del rendimiento Las técnicas incluyen el scraping concurrente con subprocesos para mayor velocidad, la agrupación de conexiones para reutilizar conexiones TCP, el almacenamiento en caché de sesiones proxy exitosas y la limitación de velocidad respetuosa.

Evitar la detección más allá de los proxies:

Decodo-Ventajas específicas:

Web scraping con Python El uso de BeautifulSoup y proxies rotativos crea programas de extracción listos para producción que evitan bloqueos, gestionan CAPTCHAs y acceden a contenido con restricciones geográficas.

La Decodo El servicio de proxy proporciona direcciones IP residenciales que aparecen como usuarios genuinos, lo que garantiza altas tasas de éxito para proyectos de recopilación de datos a gran escala.

Cómo hacer tu raspador a prueba de balas

Ahora dispone de un web scraper en producción que gestiona 115 millones de direcciones IP en 195 ubicaciones. Su código rota las direcciones automáticamente, evita los CAPTCHA y mantiene una tasa de éxito del 99.86 % sin intervención manual.

La estrategia de rotación de proxy La solución que has creado elimina bloqueos y mantiene la recopilación de datos funcionando las 24 horas del día, los 7 días de la semana. Comienza con la prueba gratuita para probar tu configuración y luego escala a miles de solicitudes por hora.

¿Qué sitio web analizarás primero con tu nuevo programa de rastreo web imparable?

Affiliate Divulgación: Esta publicación puede contener alguna affiliate enlaces, lo que significa que podemos recibir una comisión si compras algo que recomendamos sin costo adicional para ti (¡ninguno en absoluto!).

![Revisión de LunaProxy 2026: obtenga 77% de descuento [$0.7/GB] más de 200 millones de proxies 10 Revisión de LunaProxy](https://affmaven.com/wp-content/uploads/2025/01/LunaProxy-Review-5-1024x512.webp)