Ottenere blocchi IP e velocità liI mit durante lo scraping possono mandare in tilt i tuoi progetti in un batter d'occhio. Le liste proxy gratuite falliscono nel giro di poche ore e il codice di rotazione manuale si trasforma in un disastro. Creare uno scraper web in Python che non viene rilevato richiede proxy rotanti che si comportano come utenti reali.

I proxy residenziali risolvono questo problema cambiando automaticamente gli IP, bypassando i sistemi anti-bot senza codice aggiuntivo.

Ti mostreremo come impostare la rotazione proxy utilizzando Decodo, trasformando il tuo scraper in una macchina inarrestabile per la raccolta dati.

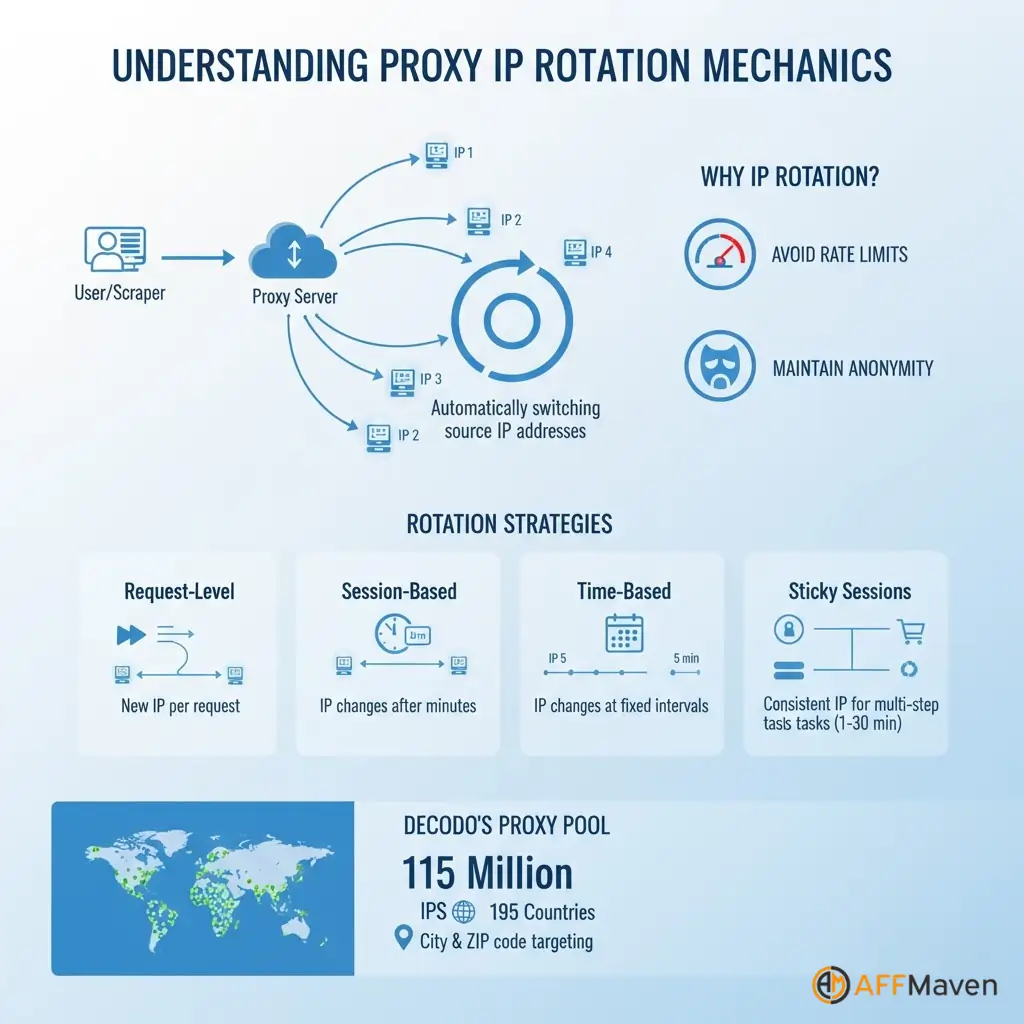

Comprensione della meccanica di rotazione proxy

La rotazione degli IP consiste nel cambiare automaticamente l'indirizzo IP sorgente a ogni richiesta o dopo intervalli predefiniti. Questa tecnica distribuisce il carico di scraping su più indirizzi, impedendo a un singolo IP di attivare i limiti di velocità.

Diverse strategie di rotazione soddisfano esigenze diverse:

Le sessioni sticky mantengono attivo temporaneamente un indirizzo IP per processi in più fasi, come l'accesso agli account o il completamento delle transazioni.

Decodo supporta sessioni fisse della durata da uno a 30 minuti, offrendoti flessibilità per flussi di lavoro complessi.

Il concetto di pool proxy fornisce l'accesso a milioni di IP residenziali da dispositivi reali in tutto il mondo. Decodo gestisce un pool di 115 milioni di IP che copre 195 paesi con un targeting granulare fino al livello di città e codice postale.

Perché la rotazione manuale crea Problematica

Costruire manualmente la logica di rotazione sembra semplice, ma crea incubi di manutenzione. È necessario proxy di origine elenca costantemente poiché i proxy gratuiti muoiono rapidamente. Testare ogni proxy prima dell'uso aggiunge latenza a ogni richiesta.

Gli elenchi proxy gratuiti presentano seri problemi:

La rotazione manuale richiede codice personalizzato per la selezione dei proxy, il rilevamento degli errori, la rimozione degli IP non funzionanti e il riavvio delle richieste. Questo lavoro infrastrutturale distoglie l'attenzione dall'effettivo estrazione dei dati attività.

Rotazione intelligente con Decodo Proxy residenziali

Decodo semplifica tutto con la gestione pool di proxy contenente 115 milioni di IP residenziali gestiti automaticamente in 195 sedi.

Il servizio fornisce una rotazione automatica integrata nell'endpoint proxy, un monitoraggio dello stato che rimuove gli IP non funzionanti e un targeting geografico per paese, città o Codice di avviamento postale precisione di livello.

| caratteristica | Rotazione manuale | Decodo Soluzione |

|---|---|---|

| Dimensioni pool IP | Limitato, instabile | Oltre 115 milioni di IP residenziali |

| Manutenzione | Aggiornamenti manuali richiesti | Monitoraggio automatico della salute |

| Tasso di successo | Variabile, spesso basso | 99.86 tasso di successo% |

| Targeting geografico | Non disponibile | Paese, città, CAP, ASN |

| Tempo di preparazione | Ore di configurazione | Minuti con API |

Iscriviti per Decodo account e vai alla dashboard del proxy. Copia il tuo nome utente, password, endpoint e porta dalla sezione credenziali.

pip install requests beautifulsoup4 lxmlimport requests

from bs4 import BeautifulSoup

import random

# Decodo rotating residential proxy configuration

DECODO_HOST = 'gate.decodo.com'

DECODO_PORT = 7000

DECODO_USERNAME = 'your_username'

DECODO_PASSWORD = 'your_password'

# Create session ID for sticky sessions

session_id = random.randint(1000, 9999)

# Format proxy URL with session management

proxy_url = f'http://{DECODO_USERNAME}-session-{session_id}:{DECODO_PASSWORD}@{DECODO_HOST}:{DECODO_PORT}'

proxies = {

'http': proxy_url,

'https': proxy_url

}

def scrape_with_rotating_proxy(url):

"""Scrape URL using Decodo rotating residential proxy"""

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36'

}

try:

response = requests.get(url, proxies=proxies, headers=headers, timeout=30)

response.raise_for_status()

soup = BeautifulSoup(response.content, 'lxml')

return soup

except requests.exceptions.RequestException as e:

print(f"Error scraping {url}: {e}")

return None

# Scrape multiple URLs with automatic rotation

urls_to_scrape = [

'https://example.com/page1',

'https://example.com/page2',

'https://example.com/page3'

]

for url in urls_to_scrape:

data = scrape_with_rotating_proxy(url)

# Process extracted dataDecodo gestisce automaticamente la rotazione IP con ogni nuovo ID di sessione, eliminando la logica manuale.

Richieste di indirizzamento geografico attraverso paesi o città specifici:

# Route through US residential IPs only

proxy_url = f'http://{DECODO_USERNAME}-country-us:{DECODO_PASSWORD}@{DECODO_HOST}:{DECODO_PORT}'

# City-level targeting

proxy_url = f'http://{DECODO_USERNAME}-city-newyork:{DECODO_PASSWORD}@{DECODO_HOST}:{DECODO_PORT}'La gestione delle sessioni persistenti mantiene lo stesso IP su più richieste:

# Use same proxy for 10 to 20 requests before generating new session

session_id = random.randint(1000, 9999)

proxy_url = f'http://{DECODO_USERNAME}-session-{session_id}:{DECODO_PASSWORD}@{DECODO_HOST}:{DECODO_PORT}'La rotazione a livello di richiesta genera la massima diversità di IP:

def get_fresh_proxy():

session_id = random.randint(1000, 99999)

return f'http://{DECODO_USERNAME}-session-{session_id}:{DECODO_PASSWORD}@{DECODO_HOST}:{DECODO_PORT}'import time

from requests.adapters import HTTPAdapter

from urllib3.util.retry import Retry

def create_session_with_retries():

"""Create requests session with automatic retries"""

session = requests.Session()

retry_strategy = Retry(

total=3,

backoff_factor=1,

status_forcelist=[429, 500, 502, 503, 504]

)

adapter = HTTPAdapter(max_retries=retry_strategy)

session.mount("http://", adapter)

session.mount("https://", adapter)

return session

def robust_scrape(url, max_retries=3):

"""Scrape with automatic proxy rotation and error handling"""

session = create_session_with_retries()

for attempt in range(max_retries):

session_id = random.randint(1000, 99999)

proxy_url = f'http://{DECODO_USERNAME}-session-{session_id}:{DECODO_PASSWORD}@{DECODO_HOST}:{DECODO_PORT}'

proxies = {'http': proxy_url, 'https': proxy_url}

try:

response = session.get(url, proxies=proxies, timeout=30)

if response.status_code == 200:

return BeautifulSoup(response.content, 'lxml')

else:

print(f"Status {response.status_code} on attempt {attempt + 1}")

time.sleep(2 ** attempt)

except Exception as e:

print(f"Attempt {attempt + 1} failed: {e}")

time.sleep(2 ** attempt)

return NoneOttimizzazione e migliori pratiche

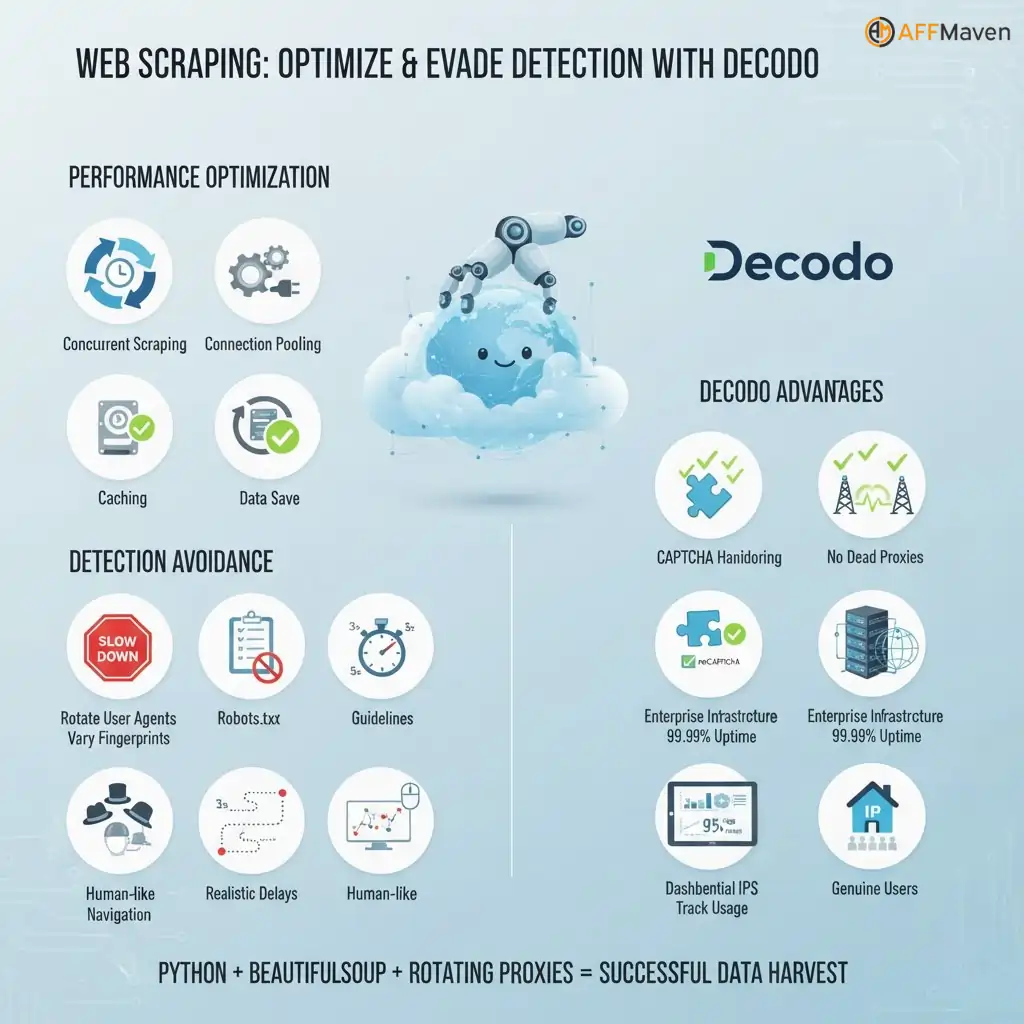

Ottimizzazione delle prestazioni Le tecniche includono lo scraping simultaneo con threading per la velocità, il pooling delle connessioni per riutilizzare le connessioni TCP, la memorizzazione nella cache delle sessioni proxy riuscite e una limitazione della velocità rispettosa.

Evitare il rilevamento oltre i proxy:

Decodo- vantaggi specifici:

Web scraping con Python Utilizzando BeautifulSoup e proxy rotanti si creano scraper pronti per la produzione che aggirano i blocchi, gestiscono i CAPTCHA e accedono a contenuti con restrizioni geografiche.

. Decodo Il servizio proxy fornisce IP residenziali che appaiono come utenti autentici, garantendo alti tassi di successo per progetti di raccolta dati su larga scala.

Rendere il tuo raschietto a prova di proiettile

Ora disponi di un web scraper di produzione che gestisce 115 milioni di IP in 195 sedi. Il tuo codice ruota automaticamente gli indirizzi, bypassa i CAPTCHA e mantiene un tasso di successo del 99.86% senza interventi manuali.

. strategia di rotazione dei proxy La soluzione che hai creato elimina i blocchi e mantiene la raccolta dati attiva 24 ore su 24, 7 giorni su 7. Inizia con la prova gratuita per testare la tua configurazione, quindi aumenta fino a migliaia di richieste all'ora.

Quale sito web analizzerai per primo con il tuo nuovo scraper non bloccabile?

Affiliate Rivelazione: Questo post potrebbe contenere alcuni affiliate link, il che significa che potremmo ricevere una commissione se acquisti qualcosa che consigliamo, senza alcun costo aggiuntivo per te (nessuno!)