Получение IP-блоков и оценка limits во время парсинга может быстро уничтожить ваши проекты. Бесплатные списки прокси перестают работать в течение нескольких часов, а код ручной ротации превращается в хаос. Создание веб-скрапера на Python чтобы оставаться незамеченным, необходимы чередующиеся прокси-серверы, которые действуют как настоящие пользователи.

Резидентные прокси-серверы решают эту проблему, автоматически переключая IP-адреса, обходя системы защиты от ботов без дополнительного кода.

Мы покажем вам, как настроить ротацию прокси-серверов с помощью Decodo, превращая ваш скрапер в неостановимую машину по сбору данных.

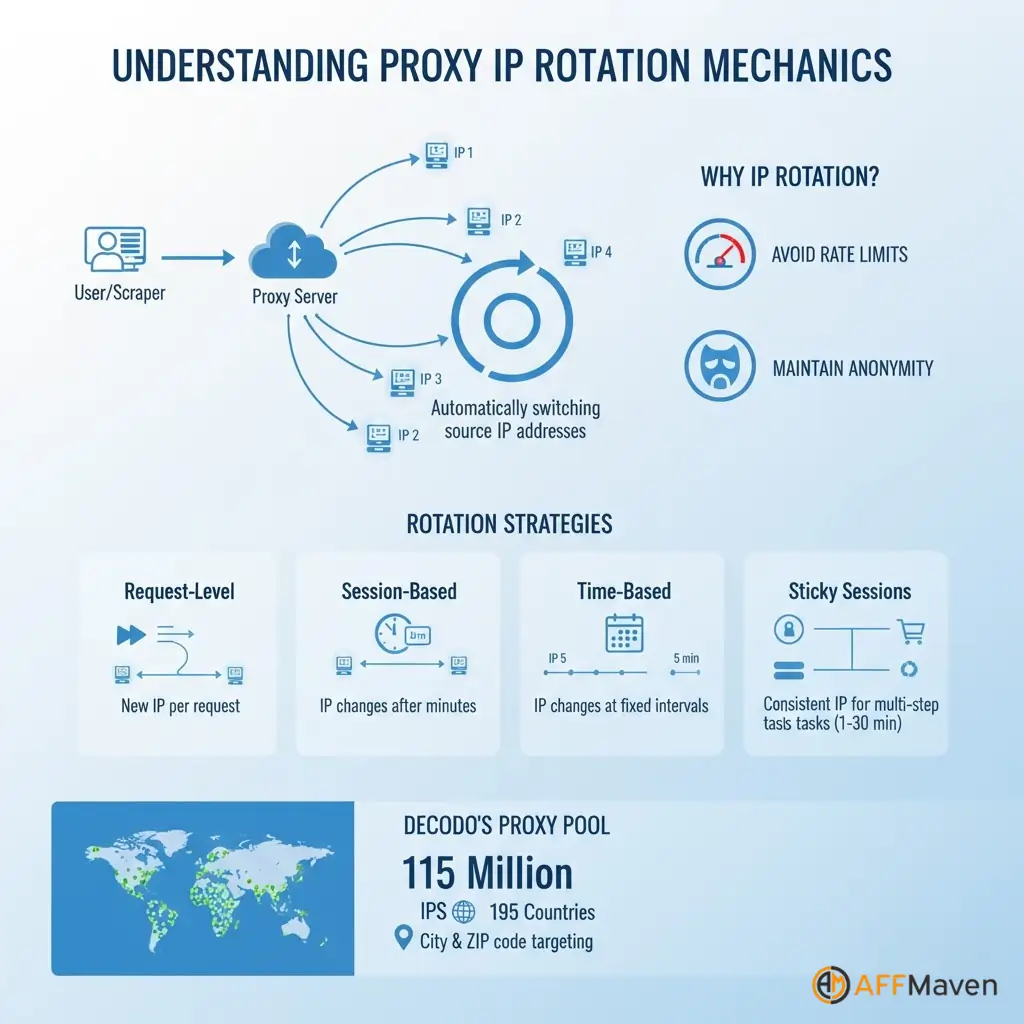

Понимание механики ротации прокси

Ротация IP-адресов означает автоматическую смену исходного IP-адреса при каждом запросе или через заданные интервалы. Этот метод распределяет нагрузку по нескольким адресам, предотвращая срабатывание ограничений скорости для любого отдельного IP-адреса.

Различные стратегии ротации отвечают разным потребностям:

Липкие сеансы временно сохраняют один IP-адрес активным для многоэтапных процессов, таких как вход в учетные записи или выполнение транзакций.

Decodo поддерживает фиксированные сеансы длительностью от одной до 30 минут, обеспечивая гибкость для сложных рабочих процессов.

Концепция пула прокси обеспечивает доступ к миллионам жилые IP-адреса с реальных устройств по всему миру. Decodo поддерживает пул из 115 миллионов IP-адресов, охватывающий 195 стран, с детализированным таргетингом вплоть до уровня города и почтового индекса.

Почему ручная ротация создает Проблемы

Создание логики ротации вручную кажется простым, но создаёт проблемы с обслуживанием. Вам нужно исходный прокси Списки постоянно обновляются, так как бесплатные прокси быстро заканчиваются. Тестирование каждого прокси перед использованием увеличивает задержку каждого запроса.

Списки бесплатных прокси-серверов создают серьезные проблемы:

Ручная ротация требует написания специального кода для выбора прокси-серверов, обнаружения сбоев, удаления неработающих IP-адресов и повторных запросов. Эта работа по развитию инфраструктуры отвлекает внимание от сути извлечение данных Задачи.

Умная ротация с Decodo Жилые прокси

Decodo упрощает все с помощью управляемого прокси-пулы содержащий 115 миллионов жилых IP-адресов, автоматически поддерживаемых в 195 местах.

Служба обеспечивает автоматическую ротацию, встроенную в конечную точку прокси-сервера, мониторинг работоспособности, который удаляет неработающие IP-адреса, и географический таргетинг по стране, городу или Почтовый индекс уровень точности.

| Особенность | Ручное вращение | Decodo Решение |

|---|---|---|

| Размер пула IP | Ограниченный, нестабильный | Более 115 миллионов резидентных IP-адресов |

| Обслуживание | Требуется обновление вручную | Автоматический мониторинг здоровья |

| Шанс успеха | Переменная, часто низкая | показатель успеха 99.86% |

| Геотаргетинг | Недоступен | Страна, город, почтовый индекс, ASN |

| Время установки | Часы настройки | Минуты с API |

Подпишитесь на Decodo аккаунт и перейдите на панель управления прокси-сервером. Скопируйте имя пользователя, пароль, конечную точку и порт из раздела «Учётные данные».

pip install requests beautifulsoup4 lxmlimport requests

from bs4 import BeautifulSoup

import random

# Decodo rotating residential proxy configuration

DECODO_HOST = 'gate.decodo.com'

DECODO_PORT = 7000

DECODO_USERNAME = 'your_username'

DECODO_PASSWORD = 'your_password'

# Create session ID for sticky sessions

session_id = random.randint(1000, 9999)

# Format proxy URL with session management

proxy_url = f'http://{DECODO_USERNAME}-session-{session_id}:{DECODO_PASSWORD}@{DECODO_HOST}:{DECODO_PORT}'

proxies = {

'http': proxy_url,

'https': proxy_url

}

def scrape_with_rotating_proxy(url):

"""Scrape URL using Decodo rotating residential proxy"""

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36'

}

try:

response = requests.get(url, proxies=proxies, headers=headers, timeout=30)

response.raise_for_status()

soup = BeautifulSoup(response.content, 'lxml')

return soup

except requests.exceptions.RequestException as e:

print(f"Error scraping {url}: {e}")

return None

# Scrape multiple URLs with automatic rotation

urls_to_scrape = [

'https://example.com/page1',

'https://example.com/page2',

'https://example.com/page3'

]

for url in urls_to_scrape:

data = scrape_with_rotating_proxy(url)

# Process extracted dataDecodo автоматически обрабатывает ротацию IP-адресов с каждым новым идентификатором сеанса, устраняя ручную логику.

Географический таргетинг направляет запросы через определенные страны или города:

# Route through US residential IPs only

proxy_url = f'http://{DECODO_USERNAME}-country-us:{DECODO_PASSWORD}@{DECODO_HOST}:{DECODO_PORT}'

# City-level targeting

proxy_url = f'http://{DECODO_USERNAME}-city-newyork:{DECODO_PASSWORD}@{DECODO_HOST}:{DECODO_PORT}'Управление сеансами для закрепленных сеансов сохраняет один и тот же IP-адрес для нескольких запросов:

# Use same proxy for 10 to 20 requests before generating new session

session_id = random.randint(1000, 9999)

proxy_url = f'http://{DECODO_USERNAME}-session-{session_id}:{DECODO_PASSWORD}@{DECODO_HOST}:{DECODO_PORT}'Ротация на уровне запросов обеспечивает максимальное разнообразие IP-адресов:

def get_fresh_proxy():

session_id = random.randint(1000, 99999)

return f'http://{DECODO_USERNAME}-session-{session_id}:{DECODO_PASSWORD}@{DECODO_HOST}:{DECODO_PORT}'import time

from requests.adapters import HTTPAdapter

from urllib3.util.retry import Retry

def create_session_with_retries():

"""Create requests session with automatic retries"""

session = requests.Session()

retry_strategy = Retry(

total=3,

backoff_factor=1,

status_forcelist=[429, 500, 502, 503, 504]

)

adapter = HTTPAdapter(max_retries=retry_strategy)

session.mount("http://", adapter)

session.mount("https://", adapter)

return session

def robust_scrape(url, max_retries=3):

"""Scrape with automatic proxy rotation and error handling"""

session = create_session_with_retries()

for attempt in range(max_retries):

session_id = random.randint(1000, 99999)

proxy_url = f'http://{DECODO_USERNAME}-session-{session_id}:{DECODO_PASSWORD}@{DECODO_HOST}:{DECODO_PORT}'

proxies = {'http': proxy_url, 'https': proxy_url}

try:

response = session.get(url, proxies=proxies, timeout=30)

if response.status_code == 200:

return BeautifulSoup(response.content, 'lxml')

else:

print(f"Status {response.status_code} on attempt {attempt + 1}")

time.sleep(2 ** attempt)

except Exception as e:

print(f"Attempt {attempt + 1} failed: {e}")

time.sleep(2 ** attempt)

return NoneОптимизация и лучшие практики

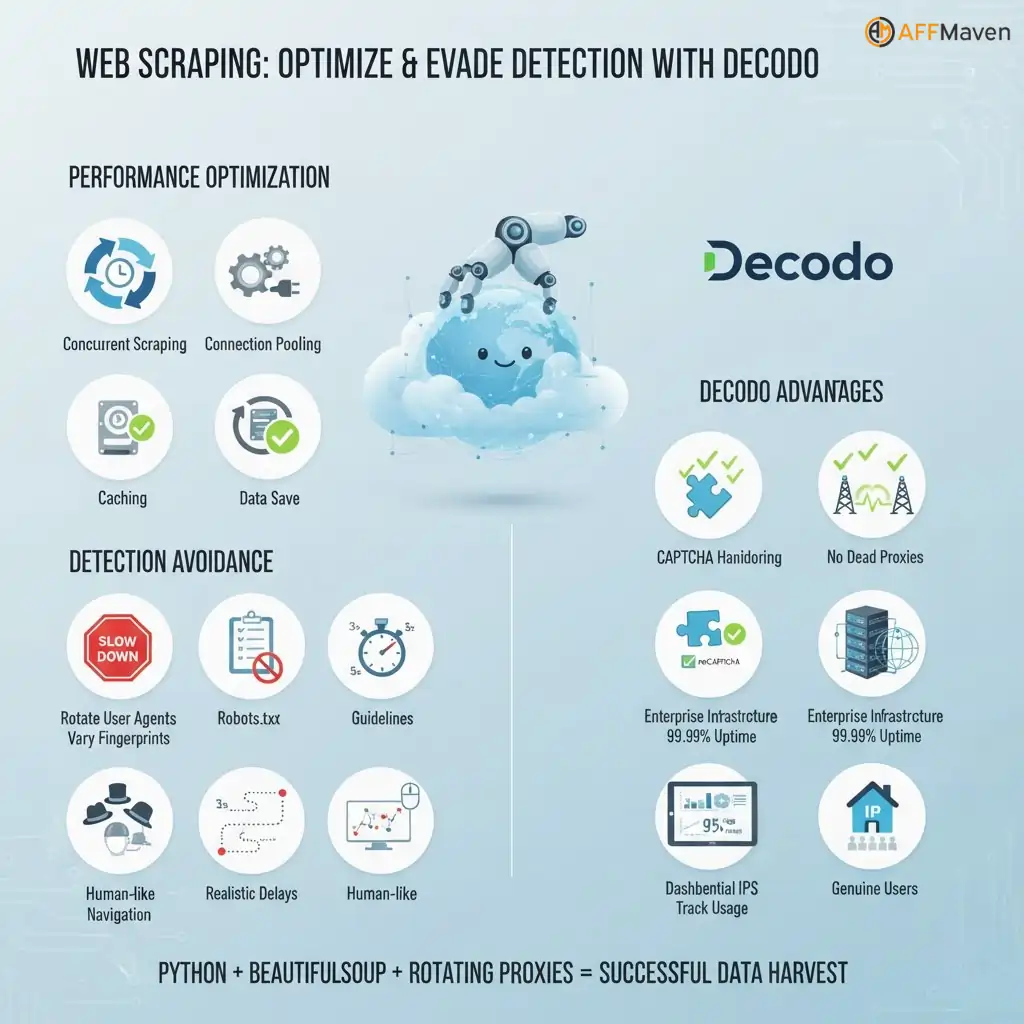

Оптимизация производительности Методы включают в себя параллельный сбор данных с потоковой обработкой для повышения скорости, пул соединений для повторного использования TCP-соединений, кэширование успешных сеансов прокси-сервера и разумное ограничение скорости.

Избежание обнаружения за пределами прокси-серверов:

Decodo-специфические преимущества:

Парсинг веб-страниц с помощью Python Использование BeautifulSoup и ротации прокси-серверов позволяет создавать готовые к использованию парсеры, которые обходят блокировки, обрабатывают CAPTCHA и получают доступ к контенту с географическими ограничениями.

Decodo Прокси-сервис предоставляет резидентные IP-адреса, которые отображаются как реальные пользователи, обеспечивая высокие показатели успешности крупномасштабных проектов по сбору данных.

Сделайте свой скребок пуленепробиваемым

Теперь у вас есть готовый веб-скрейпер, который обрабатывает 115 миллионов IP-адресов в 195 локациях. Ваш код автоматически чередует адреса, обходит CAPTCHA и обеспечивает 99.86% успешности без ручного вмешательства.

стратегия ротации прокси Созданное вами решение устраняет блокировки и обеспечивает круглосуточный сбор данных. Начните с бесплатной пробной версии, чтобы протестировать конфигурацию, а затем масштабируйте её до тысяч запросов в час.

Какой веб-сайт вы просканируете в первую очередь с помощью нового неблокируемого парсера?

Affiliate Разглашение: Этот пост может содержать некоторые affiliate ссылки, что означает, что мы можем получить комиссию, если вы покупаете что-то, что мы рекомендуем, без дополнительных затрат с вашей стороны (вообще никаких!)