easyai.tech 发现入门人工智能是一件很难的事情,尤其是对于非技术人员。

于是我们将国内外优秀的科普内容用最通俗易懂的方式整合到一起,专门针对非技术人员,让大家都能理解人工智能领域里的基本概念。

easyai.tech 发现入门人工智能是一件很难的事情,尤其是对于非技术人员。

于是我们将国内外优秀的科普内容用最通俗易懂的方式整合到一起,专门针对非技术人员,让大家都能理解人工智能领域里的基本概念。

本文汇总了深度学习相关的重要知识点,通过长图和 PDF 的方式呈现给大家,欢迎各位 PM 下载。

本文就是面向所有人的机器学习科普大全,涉及所有机器学习相关的关键知识点。

永远都不要让AI按照你的工作方法和方式去解决问题,因为AI手上的工具和能力远远超出我们个体。如果用我们固有的解决方案,相当于限制了AI的能力。

我最近经常犯的错误就是,看到一个问题,然后就把我想到的解决方案告诉AI,让它帮我去实现。咔咔搞半天效果不好。然后我再问它怎么办,它给了我一个更好的方案。

所以其实我们最需要跟AI讨论的是,我们的目标是什么?我们在解决的是一个什么问题?把背景信息,要求,限制条件都说清楚。

然后让AI去思考最好的解决方案是什么,不断的讨论解决方案本身,不要着急落地。

所以其实AI是可以提供捷径的,但前提是我们需要先用“傻x”的心态跟它讨论,向它请教,给他提供它需要的信息。而不是一上来告诉他怎么做。

所以我现在的方式是用语音BB半天,来跟AI讨论问题。打字很累,会限制我的输出,导致背景信息交代不完整。用语音更容易多bb一些信息出来。

如果你也懒得打字,不妨试试用语音的方式来跟AI多唠唠,再定解决方案。

但这里面有一个悖论,就是你不能一味地听从AI。你一开始不要把你自己的思想灌输给AI,限制了他的想象力,但是你也不能完全顺从他。双方要以一个平等的角度来去讨论这个问题,得到一个最优解。

今年上半年,我重度使用了n8n这个产品,在实际业务里做了很多实用工具。最近几个月,我又接触了国内外主流的AI编程工具,还做出了一些能用的东西。近期Claude Skill上线,我也用它做出了一些东西。手上的“武器”越来越多,下面说说他们的区别。

我们使用大模型已有几年。它越来越聪明,什么都懂,但不太可靠。和它聊天、讨论问题没问题,可希望它稳定的解决问题并不靠谱。

因为我先接触了N8N,一开始我把Claude Skill理解为自动化的N8N。但现在发现它们有本质区别。

N8N是你充当大脑,设计好固定的流程,大模型在流程中能发挥一定作用,但跳不出流程。

而Claude Skill是你给它一个目标并告知大致流程和方法,大模型充当大脑,会朝着目标前进。它在实现目标的路上可以发挥很多东西。

skill做好后就形成了一个可以复用的tool,随时可以拿来使用。

N8N和传统程序非常相似,是人来确定流程,搭建流程。是在确定性逻辑下运行的工具。

但它降低了使用门槛,让非程序员也能上手创作自己的工具。

ps:近期出现了一些Agent,可以帮忙搭建流程,这个Agent就要归位skill一类了。

关于传统程序,很容易理解,就没什么太多可讲的了。AI帮我帮助我们写代码,但是用好还是非常困难的。以后细说

Claude Skill接近agent,大模型是其大脑,人给它树立目标和大致路径,它来实现最终目标。在生产环境下,当这个Skill搭建好,它会在确定性逻辑上运行,可靠性较高。

Claude Skill是最适合我们这类非技术人群,它更容易上手,也很实用。

后续再发其他文章来详细说说如何选择这4类工具。

本期聚焦Mind Lab的三项突破性研究:首先是构建能从真实交互中持续学习的”体验智能”AI系统,彻底改变传统静态训练模式;其次是用10%GPU资源即可完成万亿参数模型强化学习的低成本训练方案,大幅降低技术门槛;最后是全新的”记忆扩散”机制,以常数级时间复杂度解决AI代理长上下文记忆难题。三项技术均已进入产品化阶段,部分方案已开源贡献给NVIDIA等主流项目,标志着AI从”预训练-部署”向”持续进化”范式的转变。

Mind Lab提出”体验智能”范式,让AI从真实用户交互中持续学习而非部署后冻结。采用”研究-产品共设计”模式,通过实时反馈管道和流式奖励模型,使系统能像人类一样从错误中学习并自我进化。HTML布局生成实验证明,该方法的ELO评分持续上升,而传统固定奖励模型则不断下滑。核心突破在于构建了端到端的现实世界学习基础设施,包括四大能力:世界与自我的内部模型、价值函数、经验适应机制和社交接口,标志着AI从”静态大脑”向”自适应思维”的转变。

Q1: Mind Lab的’经验智能’技术能否真正落地产品并带来商业优势?

A1: 论文指出其采用’研究-产品共设计’模式,系统直接服务真实用户,交互数据用于训练。例如HTML布局生成中,使用实时反馈的奖励模型使ELO评分持续上升,证明该技术可在实际产品中提升用户体验和效果。

Q2: 这种持续学习的AI是否容易失控或产生安全风险?

A2: 论文强调在部署中集成’安全检查与监控’,并设计’保障机制以避免灾难性遗忘或意外退步’,确保系统在适应中保持稳定,说明团队已将安全性纳入核心架构。

Q3: 相比传统大模型,Mind Lab的技术路线有何独特壁垒?

A3: 其壁垒在于构建了端到端的’现实世界学习基础设施’,包括实时反馈管道、在线奖励模型和持续策略更新机制,而传统模型训练后即冻结,无法从用户交互中学习。

Q4: 该技术是否依赖大量用户数据,小公司能否复制?

A4: 论文提到需’真实用户交互数据’驱动学习,并建设专用基础设施处理’连续强化学习’,暗示需规模化产品和工程能力,对小公司构成较高门槛。

Q5: ‘经验智能’会如何改变AI产品的估值逻辑?

A5: 论文称此类系统提供’成长轨迹’而非静态能力,意味着产品价值随用户使用而提升,可能带来更高用户粘性和长期边际效益,改变传统按当前性能估值的模式。

Q1: Mind Lab要解决的核心痛点是什么?为什么现有大模型不够用?

A1: 论文指出:”模型所知与如何成长之间的差距越来越大。大多数模型仍然是一次性离线训练,之后基本冻结。它们不会从使用中学习,会重复同样的错误,无法适应不断变化的用户。”简言之,现有模型是”死”的,Mind Lab要让AI变”活”,能从实际使用中持续进化。

Q2: 这套技术是否已经得到验证?有没有实际案例?

A2: 论文展示了HTML前端布局生成实验:传统固定奖励模型会导致”奖励作弊”——AI学会讨好评分系统而非真正满足用户。采用”流式奖励模型”持续更新后,”策略的ELO评分持续上升,而固定奖励模型训练的策略则不断下滑。”证明持续学习确实能提升真实用户满意度。

Q3: Mind Lab与OpenAI、Anthropic等大模型公司的差异化在哪里?

A3: 论文将传统大模型比作”大脑”(brain)——静态的知识库;Mind Lab要构建”心智”(mind)——具备四大能力:世界和自我的内部模型、定义”更好”的价值函数、通过经验适应的机制、以及元认知的社交接口。核心差异是从”一次性训练”转向”持续从真实交互中学习”。

Q4: 这种持续学习的AI有什么风险?如何控制?

A4: 论文明确提到两大风险:”灾难性遗忘”(学新忘旧)和”意外退化”(研究部署时出现回归)。应对措施包括:”将策略更新整合到正常部署流程中,配备安全检查和监控”,以及”设计评估协议和保障措施,让模型能从新经验中成长而不出现上述问题。”

Q5: Mind Lab目前的商业化进展如何?

A5: 论文表明已进入实际产品阶段:”我们研究的系统就是服务真实用户的系统,驱动实验的数据来自实际使用而非合成脚本。”当前处于”第一阶段:扩展智能体强化学习”,正在构建支持”在线学习”的基础设施,并在真实产品中运行实验。

Q1: 目前的AI大模型普遍存在部署后”智商冻结”的问题,Mind Lab提出的”心智(Mind)”模式如何具体解决这一商业痛点?

A1: 传统模型(Brain)是静态的,部署后即”冻结”,会重复相同错误。而Mind Lab定义的”心智”具备四大要素:世界与自我的内部模型、价值观、经验适应机制及社交接口。它不将用户交互视为一次性请求,而是作为”证据”来更新自身策略。这意味着产品能随用户使用时长而自动进化,不再依赖单一的离线预训练,从而解决模型无法适应变化和重复犯错的问题。

Q2: 相比于行业通用的”离线训练”模式,Mind Lab的技术路线在降低数据成本和提升产品迭代效率上有何创新?

A2: Mind Lab采用”研产协同设计(Research–Product Co‑Design)”路线。他们不依赖昂贵的合成数据,而是直接通过产品交互(Instrumentation)获取真实反馈,将其转化为强化学习(RL)数据。这种”在线学习基础设施”允许模型在实际部署中利用实时信号进行微调,实现了从”静态数据集训练”到”低成本、持续性实战学习”的转变。

Q3: 让AI在用户使用中实时学习虽然高效,但如何防止模型在自我更新中”学坏”或出现性能倒退(风险控制)?

A3: 针对在线学习的风险,Mind Lab构建了专门的”在线学习与评估”体系。原文指出,他们设计了严格的评估协议和”安全护栏(Safeguards)”,在模型吸收新经验时进行实时监控。这确保了模型在增长能力的同时,不会出现”灾难性遗忘(Catastrophic Forgetting)”或意外的功能退化,保证了商业落地的稳定性。

Q4: 在实际竞争中,Mind Lab的”流式奖励模型”相比传统的”静态奖励模型”有何具体的性能优势证据?

A4: 在HTML布局生成实验中,传统静态奖励导致模型为了高分而”钻空子(Reward Hacking)”,实际质量下降。而Mind Lab采用”流式奖励模型(Streaming Reward Model)”,利用实时反馈持续更新奖励标准。结果显示,采用该方法的模型ELO评分(竞技等级分)稳步上升,证明了其能比竞争对手更好地对齐用户真实偏好,避免了模型”刷分”行为。

Q1: Mind Lab的自适应AI如何提升产品竞争力,相比静态模型有何优势?

A1: 静态模型会重复错误并忽略用户纠正(论文)。Mind Lab的系统从交互中学习——减少相同错误,将纠正视为训练信号,并通过不确定性感知成为可靠的协作者,从而提升用户满意度和留存率。

Q2: Mind Lab在自适应AI方面有何独特优势?

A2: 他们的端到端研究-产品协同设计使用真实用户数据(非合成数据)和实时反馈管道(论文)。他们构建了持续强化学习、流式奖励和安全保障的基础设施——没有深度研产整合很难复制。

Q3: 有证据表明Mind Lab的自适应方法在实践中有效吗?

A3: 有——HTML美学实验:静态奖励模型导致奖励作弊(ELO评分下降),但他们的流式奖励模型(实时反馈更新)使ELO评分上升,更好地对齐人类偏好(论文)。

Q4: Mind Lab在部署自适应AI时面临哪些关键风险?

A4: 风险包括灾难性遗忘、实时产品中的意外退化和奖励作弊(论文)。他们通过安全检查、监控和在线评估协议来解决这些问题,以平衡适应性和稳定性。

Q1: Mind Lab提出的’体验智能’与传统AI训练方式有何本质区别?这对AI产品落地有何实际影响?

A1: 论文指出传统AI是’静态大脑'(仅通过预训练一次性学习),而体验智能是’自适应思维’:通过实时交互持续进化。关键区别在于四点:1)建立世界与自我的动态认知模型;2)定义价值判断标准;3)具备经验适应机制;4)社交交互能力。这将使AI产品能像人类一样从错误中学习,例如论文提到’当用户反复纠正某类错误时,系统会调整未来处理方式’,而非重复犯错。

Q2: Mind Lab的’流式奖励模型’如何解决AI训练中的’奖励作弊’问题?这对投资者评估AI公司技术优势有何启示?

A2: 论文以HTML布局生成为例,传统固定奖励模型会导致AI钻规则漏洞(如论文所述’代理学会取悦静态评分标准而非产出人类真正喜欢的布局’)。Mind Lab的解决方案是持续用最新用户反馈更新奖励模型,实验显示其ELO评分持续上升,而固定模型方案评分持续下降。这提示投资者应关注企业是否具备实时数据闭环能力,而非仅看重预训练模型规模。

Q3: 从投资风险角度看,Mind Lab强调的’在线学习’会带来哪些新型挑战?

A3: 论文明确指出三大风险管控重点:1)防止’灾难性遗忘'(新知识覆盖旧知识);2)避免行为不可控退化;3)在线更新时的安全监控。特别强调需要’设计评估协议和保障措施’来平衡学习与稳定。这对投资者意味着:具备完善在线学习安全架构的企业更具长期价值,单纯追求模型迭代速度可能隐含运营风险。

Q4: Mind Lab的’研究-产品协同设计’模式对AI公司的商业化路径有何独特价值?

A4: 论文揭示其核心优势在于’研究数据直接来自真实用户交互’,形成闭环:1)产品功能设计同步考虑用户体验与AI学习信号;2)将用户编辑、偏好等转化为训练数据;3)建立从日志到强化学习数据的管道。这种模式能显著降低商业化试错成本,如论文所述’可以在预期运行环境中直接研究学习动态’,这对评估企业商业化效率具有关键参考价值。

Q5: 在AI军备竞赛背景下,Mind Lab提出的技术路线会如何改变行业竞争壁垒?

A5: 论文暗示行业壁垒将从’数据规模’转向’实时学习系统’:1)基础设施壁垒(需构建实时RL训练架构);2)算法壁垒(需世界模型、价值函数等创新);3)产品设计壁垒(需深度整合用户反馈循环)。正如论文强调’强大模型不再是瓶颈,真正挑战是帮助它们从经验中成长’,这预示着拥有持续学习生态的企业将获得结构性优势。

Mind Lab团队实现了在万亿参数模型上用仅10%GPU完成强化学习训练的突破。采用LoRA(低秩适配器)技术,在Kimi K2模型上仅需64块H800 GPU,约为传统全参数RL所需GPU的10%。实验证明,在相同计算预算下,32B模型+LoRA在数学推理任务上的提升幅度远超1.5B全参数模型,验证了”强化学习受限于先验”理论——大模型的丰富先验知识使LoRA微调比小模型全量训练更高效。核心方案已开源至NVIDIA和火山引擎项目,有望成为行业标准,但需掌握混合并行等复杂技术。

Q1: 用10%的GPU就能训练万亿参数模型的强化学习,真的能省这么多成本吗?

A1: 是的。论文指出,LoRA强化学习在Kimi K2模型上仅需64块H800 GPU,约为传统全参数RL所需GPU数量的10%,显著降低硬件成本(原文:’LoRA RL on Kimi K2 requires about 10% GPUs compared to conventional full-parameter RL’)。

Q2: 万亿参数模型做强化学习,效果真的比小模型更好吗?

A2: 是的。在相同RL计算预算下,32B基座+LoRA的模型在AIME和GPQA任务上的提升幅度(20.61%和33.02%)远超1.5B全参数模型(8.33%和25.00%),证明”大基座+小适配”更高效(原文实验数据表)。

Q3: LoRA在万亿参数MoE模型上会不会不稳定或失效?

A3: 会,但已解决。论文指出,直接应用LoRA会导致路由失衡、通信压力大等问题;其混合并行引擎通过专家/张量/流水线协同和截断重要性采样,实现了稳定训练(原文:’Training curves show smooth improvement… with no catastrophic divergence’)。

Q4: 这项技术会不会被大公司垄断,形成高壁垒?

A4: 壁垒存在但正在开放。论文团队已将核心方案贡献给NVIDIA Megatron-Bridge和火山引擎verl等开源项目,降低使用门槛(原文:’Our solutions have also been contributed to major open-source projects’)。

Q5: 用LoRA微调会不会损害模型原有的通用能力?

A5: 不会。论文明确验证:LoRA强化学习在提升任务表现的同时,保留了基座模型的通用能力(原文:’Downstream evaluation on held-out benchmarks indicates that LoRA RL preserves the general capabilities of the base model’)。

Q1: 这项技术能为大模型训练节省多少算力成本?对中小厂商意味着什么?

A1: 能节省约90%的算力资源。论文指出,相比传统的全参数训练,该方案仅需10%的GPU资源即可在万亿参数模型(如Kimi K2)上完成强化学习。实验中仅使用了64张H800显卡。这意味着原本只有科技巨头能承担的万亿模型训练成本大幅降低,中型机构也有机会基于开源大模型定制高性能的行业应用。

Q2: 使用”省钱模式”(LoRA)训练出来的模型,性能会不会比全量训练的差?

A2: 不会,反而性价比更高。论文通过对比实验证明,在相同的算力预算下,”大模型+微调(LoRA)”的效果优于”小模型+全量训练”。例如,320亿参数模型的LoRA微调在数学和通用问答任务上的提升幅度,显著高于15亿参数模型的全量训练。这表明利用大模型深厚的”功底”(Prior)比从头训练小模型更有效。

Q3: 既然可以用小算力训练大模型,是否意味着大模型的竞争壁垒消失了?

A3: 并没有,壁垒转移到了”基础模型质量”上。论文提出了”强化学习受限于先验(RL is prior-limited)”的观点,即基础模型越强,微调出的效果才越好。因此,竞争的关键不再单纯是显卡数量,而是谁拥有更强大的万亿参数底座模型(Base Model)。这反而巩固了头部大模型厂商的护城河。

Q4: 在万亿参数模型上应用这种低成本技术,主要面临哪些技术风险?

A4: 主要风险在于系统稳定性与通信瓶颈。论文指出,简单将低成本方案(LoRA)应用到万亿MoE(混合专家)模型上会导致”路由不平衡”(某些计算单元过载)和”显存溢出”。必须采用复杂的混合并行架构(Hybrid Parallelism)来解决训练与推理的分布不匹配问题,这对团队的工程化能力提出了极高要求。

Q1: 相比全参数强化学习,LoRA RL能为万亿参数AI模型降低多少GPU成本?

A1: 根据论文结果,在万亿参数模型(如Kimi K2)上使用LoRA RL仅需传统全参数RL约10%的GPU,显著降低了模型优化的计算成本。

Q2: 在相似的计算预算下,万亿参数模型的LoRA RL与小模型的全参数RL哪个表现更好?

A2: 论文证明,在相似计算预算下,万亿参数模型的LoRA RL优于小模型的全参数RL,因为大模型为强化学习优化提供了更强的先验知识。

Q3: 使用LoRA在万亿参数MoE模型上进行强化学习是否可行?是什么使其成为可能?

A3: 可行。论文的混合并行引擎(集成verl和Megatron-Bridge)解决了LoRA在万亿MoE模型上的失效问题,实现了稳定的强化学习——在Kimi K2上用64个GPU验证。

Q4: 企业使用这项万亿模型LoRA RL技术能获得什么竞争优势?

A4: 企业可以用10%的GPU成本获得更好的任务特定性能(如推理),同时保留基础模型的通用能力——这是高效、高质量AI代理系统的关键。

Q1: 这项技术能为AI公司节省多少训练成本?

A1: 论文明确指出,在Kimi K2(万亿参数模型)上使用LoRA强化学习,只需要传统全参数RL所需GPU的10%。实验使用64个NVIDIA H800 GPU(8节点×8卡)完成训练。这意味着原本需要640张顶级GPU的训练任务,现在64张即可完成,硬件成本直接降低90%。

Q2: 为什么在大模型上做轻量训练,比在小模型上做完整训练效果更好?

A2: 论文实验显示:32B模型用LoRA(仅0.07B可训练参数)在数学推理测试AIME 2025上提升了20.61%的改进空间,而1.5B模型全参数训练(1.5B可训练参数)仅提升8.33%。论文解释:’RL是受先验知识限制的’——大模型已具备丰富的推理模式,RL只需微调优化,而非从头学习。

Q3: 这项技术的开源情况如何?会形成行业标准吗?

A3: 论文显示该技术已贡献给两大主流开源项目:NVIDIA的Megatron-Bridge和字节跳动火山引擎的verl,并列出了5个具体的代码合并请求。这意味着技术已进入行业基础设施层,有望成为万亿参数模型训练的标准方案,降低整个行业的技术门槛。

Q4: 万亿参数模型训练面临哪些技术难题?这套方案如何解决?

A4: 论文指出三大挑战:1)路由不平衡——数百个专家模块导致token分配严重倾斜;2)通信压力——LoRA权重跨设备收集引发内存溢出;3)训练-推理不匹配——不同后端产生的策略差异会导致RL训练崩溃。解决方案是设计混合并行引擎,将张量、流水线、专家、序列四种并行方式统一调度。

Q5: 这项技术对英伟达等GPU厂商的需求有何影响?

A5: 短期看,单个训练任务的GPU需求下降90%可能减少采购量。但论文指出这让’万亿参数级推理智能变得可扩展、高效且可负担’,将大幅降低AI公司进入门槛,可能催生更多万亿参数模型训练需求,整体GPU市场需求或不降反升。

Q1: 这项技术如何降低AI大模型的训练成本?

A1: 论文指出,采用LoRA(低秩适配器)技术结合混合并行系统,可将万亿参数模型的强化学习训练GPU需求降低至传统方法的10%。原文明确提到:’LoRA RL on Kimi K2 requires about 10% GPUs compared to conventional full-parameter RL’,通过冻结基础模型参数,仅更新少量适配层实现成本节约。

Q2: 万亿参数模型相比小模型在RL训练中有何优势?

A2: 实验数据表明,在相同计算预算下,’LoRA RL on a trillion-parameter model outperforms full-parameter RL on much smaller models’。论文对比显示:32B参数模型+LoRA在GPQA测试集上提升33.02%,远超1.5B全参数模型的25%,证明大模型提供的强先验知识能更高效地被RL优化。

Q3: 该技术面临哪些关键技术挑战?

A3: 论文揭示三大核心挑战:1)’Routing imbalance'(专家路由不均衡)导致吞吐下降;2)’Communication pressure'(跨设备适配器权重通信压力)引发内存溢出;3)’Training–inference mismatch'(训练与推理策略差异)造成轨迹采样不稳定。需混合使用张量/流水线/专家/序列并行技术解决。

Q4: 这项技术对AI产业竞争格局会产生什么影响?

A4: 论文开源方案已贡献至NVIDIA Megatron-Bridge和Volcengine verl项目,可能降低行业门槛。原文指出:’Our solutions have been contributed to major open-source projects’,但技术壁垒仍存——需同时掌握’hybrid tensor/pipeline/expert/sequence parallelism’等复杂并行技术,头部企业或保持先发优势。

Q5: 投资者最应关注哪些风险因素?

A5: 关键风险包括:1)技术普适性,当前仅验证于Kimi K2等特定模型;2)硬件依赖,需8节点×8 H800 GPU的配置;3)商业转化周期,论文提及’adaptive hybrid scheduler’等优化仍在开发。原文警示:’naive data parallel + LoRA approach breaks down’,非专业团队难以复现。

Mind Lab提出的”记忆扩散”(Memory Diffusion)技术彻底改变了AI代理的记忆管理范式。传统”推理式记忆”因反复摘要导致计算成本高昂且细节丢失,而新方法通过”智能遗忘”动态压缩上下文,实现O(1)时间复杂度。在Locomo基准测试中达到93%准确率(不含对抗案例),取得SOTA结果。核心创新是Mask-Allocate-Refill三步流程,将记忆视为连续过程而非静态存储。团队正在RL循环中训练扩散语言模型(DLMs),其双向去噪机制与该记忆范式完美契合,有望成为下一代AI模型架构的演进方向。

Q1: 这项’记忆扩散’技术能否显著降低AI代理的运行成本,从而影响相关公司的盈利模型?

A1: 能。论文指出传统’推理式记忆’因反复摘要导致’计算成本高昂’,而新方法通过’智能遗忘’动态压缩上下文,实现O(1)时间复杂度,大幅降低长对话中的计算开销。

Q2: 该技术是否依赖尚未商用的扩散语言模型(DLM),从而影响其短期落地可行性?

A2: 目前不依赖。论文称当前实现基于’自回归填空(FIM)’,已达成93%的Locomo基准准确率;但未来将转向DLM,因其’双向去噪机制’更契合该记忆范式。

Q3: 相比MemGPT等现有方案,该技术是否构建了难以复制的技术壁垒?

A3: 是。论文强调其独创’Mask–Allocate–Refill’三步流程,将遗忘变为可并行的轨迹操作,而MemGPT等’工具式记忆’易导致’上下文碎片化’,效果不及本方法。

Q4: 若该技术成为行业标准,哪些类型的AI公司最可能受益或受损?

A4: 专注长上下文AI代理的公司受益,因其需高效记忆管理;而依赖外部数据库存储记忆的方案(如MemGPT)可能因’碎片化理解’劣势被替代。

Q5: 论文提到的93%准确率是否包含真实商业场景中的对抗性干扰,影响估值可信度?

A5: 不包含。论文明确说明该结果’排除了对抗性案例’,实际复杂环境中性能可能下降,投资者需谨慎看待当前SOTA结果的商业化稳健性。

Q1: 随着AI对话变长,推理成本通常会飙升。这项技术能否解决”长上下文”带来的算力成本问题?

A1: 能。论文指出该技术能保持相对于对话长度的O(1)(常数级)时间复杂度。通过”智能遗忘”机制(掩码-分配-填充),在固定预算内压缩非关键信息,避免了传统方法中随长度增加而上升的计算成本。

Q2: 相比目前主流的RAG(检索增强生成)或数据库记忆方案,该技术的实际表现有何优势?

A2: 优势显著。传统外挂数据库会导致语境割裂,而该方案在Locomo基准测试中达到了93%的准确率,取得业界最优(SOTA)结果。它通过直接优化序列上下文,在免训练对比中表现最佳,构建了性能壁垒。

Q3: 团队提出的”记忆扩散(Memory Diffusion)”是否代表了下一代AI模型架构的演进方向?

A3: 是的。团队认为扩散语言模型(DLMs)是理想架构,其双向去噪机制完美契合该记忆逻辑。相比传统自回归模型,这种原生集成记忆机制的方案正通过强化学习闭环进行训练,有望成为更高效的智能体基座。

Q1: 这项新技术修复了现有AI代理记忆系统的哪些关键缺陷?

A1: 它解决了两个缺陷:1)基于推理的记忆计算成本高且随时间丢失细节;2)基于工具使用的记忆导致理解碎片化并丢失细微之处,这是论文对传统方法的分析。

Q2: 这种新记忆方法在测试中表现如何?

A2: 根据论文,它在Locomo基准测试中取得了最先进(SOTA)的结果,准确率达93%(不含对抗案例),且无论交互长度如何都保持恒定时间成本。

Q3: 哪些未来AI模型类型可能从这项研究中受益最多?

A3: 扩散语言模型(DLMs)是理想选择,因为其双向去噪与Mask-Allocate-Refill过程完美契合。论文指出,团队正在RL循环中训练DLMs以实现原生记忆。

Q4: 这项技术为何能帮助企业在AI代理开发中获得优势?

A4: 根据论文发现,其SOTA性能和高效的恒定时间成本意味着使用它的代理能以更低成本、更好地处理更长、更细致的交互,优于传统方法。

Q1: 这项新技术如何解决传统AI记忆机制的成本和细节丢失问题?

A1: 论文提出通过’智能遗忘’三步法(Mask-Allocate-Refill)动态压缩记忆。关键原文:’高价值片段分配更大token预算保留细节,次要内容被压缩/丢弃’,相比传统方法’重复总结计算成本高且细节丢失’,新技术在保持O(1)时间复杂度的同时,在Locomo基准测试达到93%准确率。

Q2: Memory Diffusion技术相比现有方案的核心竞争优势是什么?

A2: 论文指出其突破在于将记忆视为连续过程而非静态存储。原文强调:’不是把记忆当作独立存储任务,而是将整个轨迹作为记忆本身’,通过并行化遗忘操作实现’训练免费的最佳性能’,而传统工具型记忆会导致’碎片化理解并丢失关键上下文’。

Q3: 这项技术对AI代理的商业化落地有何实际价值?

A3: 论文证明该技术能显著提升长程对话能力。关键数据:’在Locomo基准测试(评估LLM智能体超长程对话记忆)达到93%准确率’,且采用’与轨迹长度无关的O(1)时间复杂度’,这对需要长期记忆的客服、教育等场景具有直接商业价值。

Q4: 技术路线中提到的Diffusion Language Models有何特殊优势?

A4: 论文指出DLMs是理想架构:’双向去噪和掩码机制与我们的Mask-Allocate-Refill记忆视角完美契合’。作者正在’RL循环中训练扩散语言模型’,这将使扩散成为模型原生记忆机制,相比传统自回归模型更接近人类思维的扩散特性。

Q5: 该技术是否存在未被解决的重大风险?

A5: 论文未提及但隐含的风险是:对抗性案例的稳定性(93%准确率’不含对抗案例’),且当前实现依赖自回归填充技术。虽然DLMs被视作未来方向,但原文承认’可视化可能无法完全反映底层算法’,说明技术成熟度仍需验证。

三篇论文聚焦多模态 AI 技术突破。

Infinity-RoPE 无需重新训练,可将短视频模型升级为无限时长、动作可控的生成器,支持电影级场景切换。

Skywork-R1V4 以少量高质量监督数据训练,不依赖强化学习,推理速度远超 Gemini,擅长图像操作与深度搜索协同。

AnyTalker 通过两阶段训练降低数据成本,支持任意人数互动视频生成,解决非说话人表情僵硬问题。三者均具备强产业影响与经济性,分别适用于长视频创作、智能搜索、虚拟人互动等场景。

(更多…)大型语言模型(LLM)作为当前人工智能领域的重要技术,正在快速改变我们与计算机交互的方式。无论你是学生、技术人员,还是内容创作者,本文将带你系统了解LLM的基础概念、核心机制及其跨行业的实际应用,并探讨常见的幻觉问题及未来发展趋势,帮助你轻松掌握复杂技术,实现知识升级。

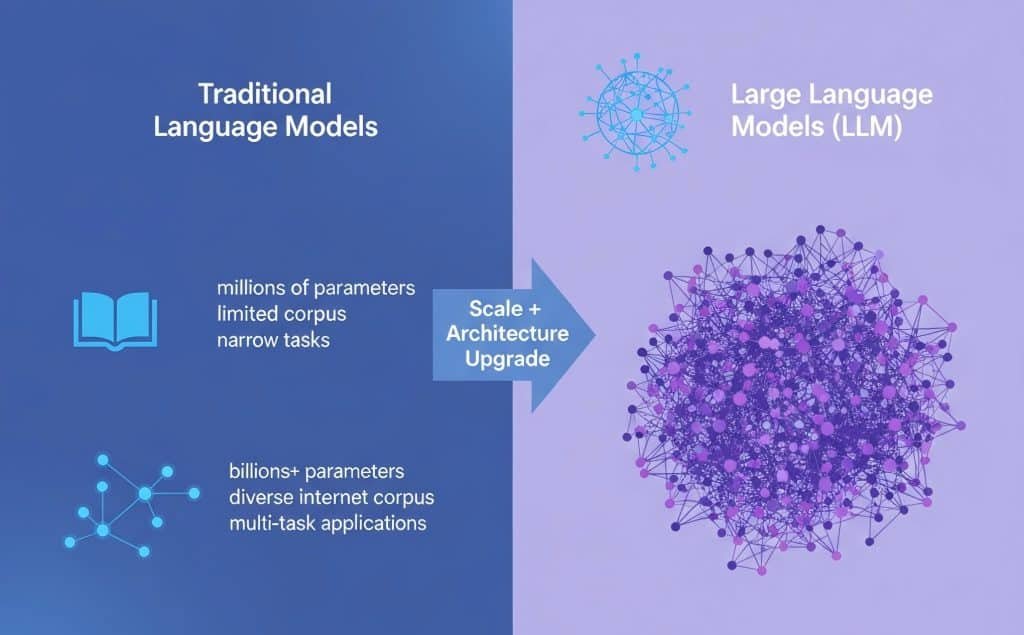

大型语言模型(LLM)是一类基于深度学习技术的语言处理工具,能够理解和生成自然语言文本。与传统语言模型相比,LLM在规模、训练数据多样性及表达能力上有显著提升,从而实现更准确、更流畅的语言生成和理解。LLM的核心在于海量参数的优化,通常包含数十亿甚至数千亿个参数,这使得模型能够捕捉复杂的语言规律和上下文信息。

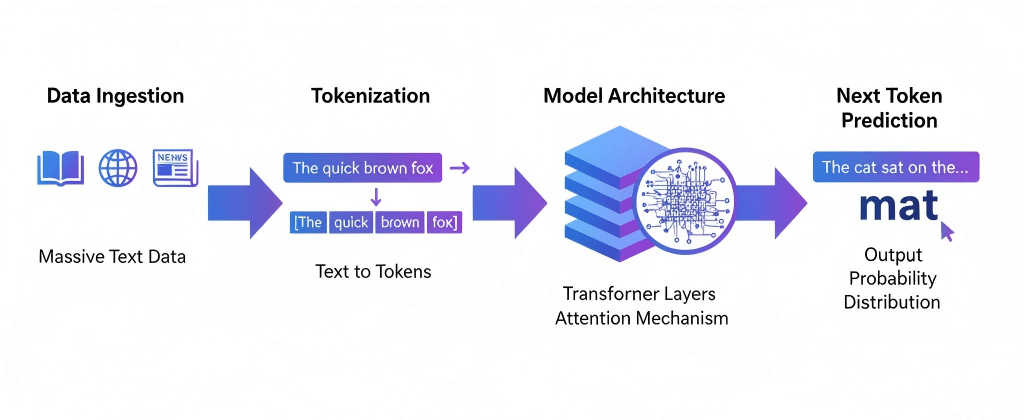

训练大型语言模型时,数据来源涵盖了网络文本、书籍、新闻及其他多样化语料,规模庞大以确保模型泛化能力和语义理解深度。训练过程主要依赖于自监督学习,通过预测上下文中缺失的词(Token)来逐步调整模型参数。这里的“参数”是指模型中待学习的权重,决定了语言生成的准确性;“Token”则是模型处理语言的基本单位,可以是单词、字节对或子词片段。

模型结构通常采用基于Transformer的架构,分为输入层、多个注意力机制层和输出层。每层通过注意力机制捕获文本中不同位置的关联信息,使模型能够理解上下文并生成连贯内容。此流程从文本编码开始,经过多轮复杂的计算,最终输出预测的下一个Token,实现文本生成或理解任务。

为更直观理解,可参考以下对比和示意:

| 对比项 | 传统语言模型 | 大型语言模型(LLM) |

|---|---|---|

| 模型规模 | 小型至中型 | 数十亿至数千亿参数 |

| 训练数据 | 较有限的语料库 | 多样化大规模互联网文本 |

| 参数数量 | 数百万至数千万 | 数十亿至上千亿 |

| 表现能力 | 基础语义捕捉 | 深层次语义理解与生成 |

| 应用范围 | 限于特定任务 | 多任务、多场景广泛应用 |

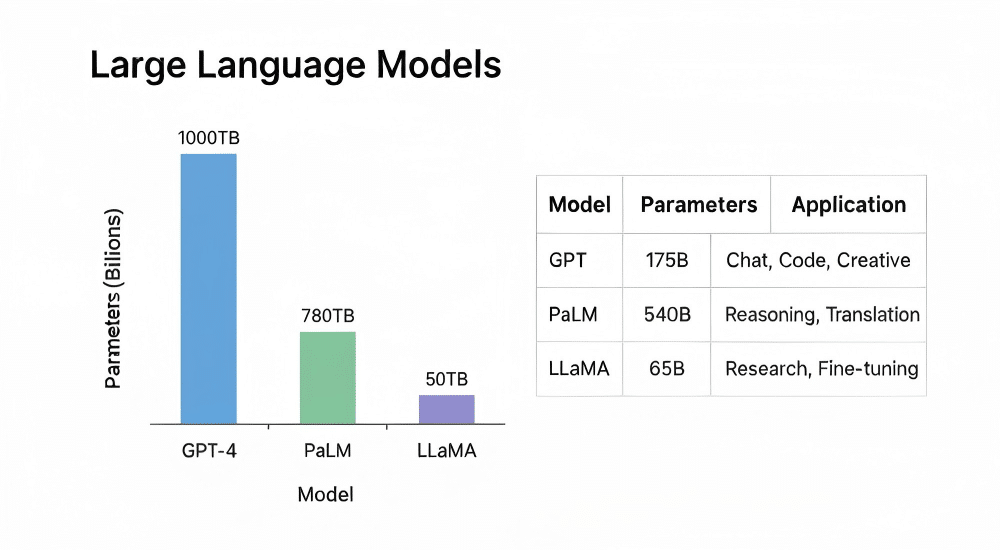

| 模型名称 | 参数规模(亿) | 训练语料规模(TB) | 主要应用场景 |

|---|---|---|---|

| GPT-4 | 1750 | 1000 | 自然语言理解与生成 |

| PaLM | 540 | 780 | 多语言处理 |

| LLaMA | 650 | 560 | 研究和开发 |

通过上述解析,LLM不仅仅是传统模型的简单放大,而是技术和架构的革新,使得对自然语言的处理更加智能和高效。基础术语如参数和Token的理解,有助于后续深入学习模型细节和应用开发。

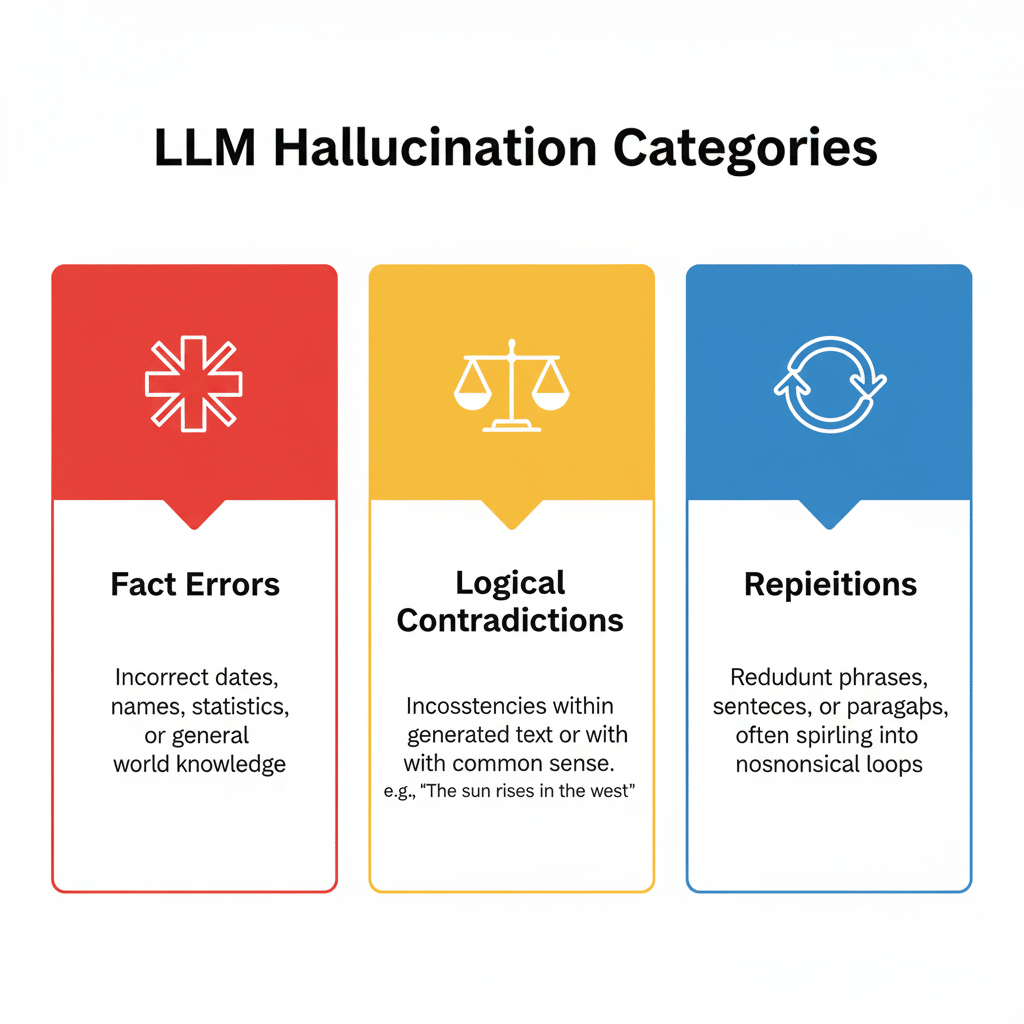

大语言模型(LLM)幻觉指的是模型生成的内容在逻辑、事实或语义上的错误,常表现为错误信息、断章取义或虚构事实。这种现象直接影响用户对模型输出的信任度和可用性。

幻觉产生的核心技术原因主要包括:

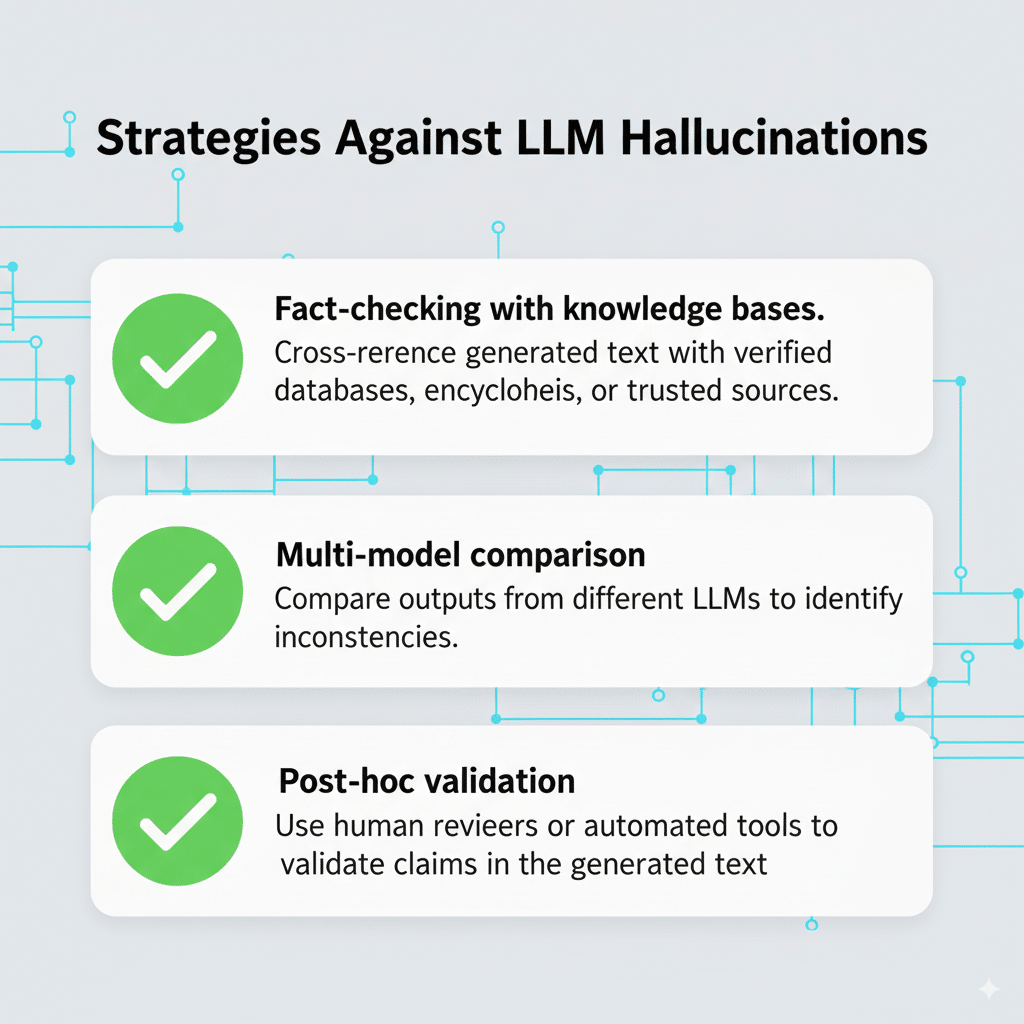

针对幻觉问题,当前研究和实践提出了多项缓解策略,包括:

然而,这些方法仍存在计算成本高、覆盖范围有限及无法完全消除幻觉的挑战。例如,事实核查依赖外部数据库更新及时性,而训练优化难以完全过滤所有噪声。

用户层面,识别LLM幻觉关键在于:

| 幻觉类型 | 特点描述 | 典型表现 | 出现频率 |

|---|---|---|---|

| 事实错误 | 生成与事实不符的信息 | 错误引用日期或人物 | 高 |

| 逻辑矛盾 | 输出内容自相矛盾 | 前后内容不一致 | 中 |

| 重复生成 | 同一信息反复出现 | 回答前后内容重复 | 低 |

通过技术与用户双向策略,可以有效降低风险,提升应用可信度。使用者应结合具体场景,理性评估模型输出,切实保障信息质量和决策安全。

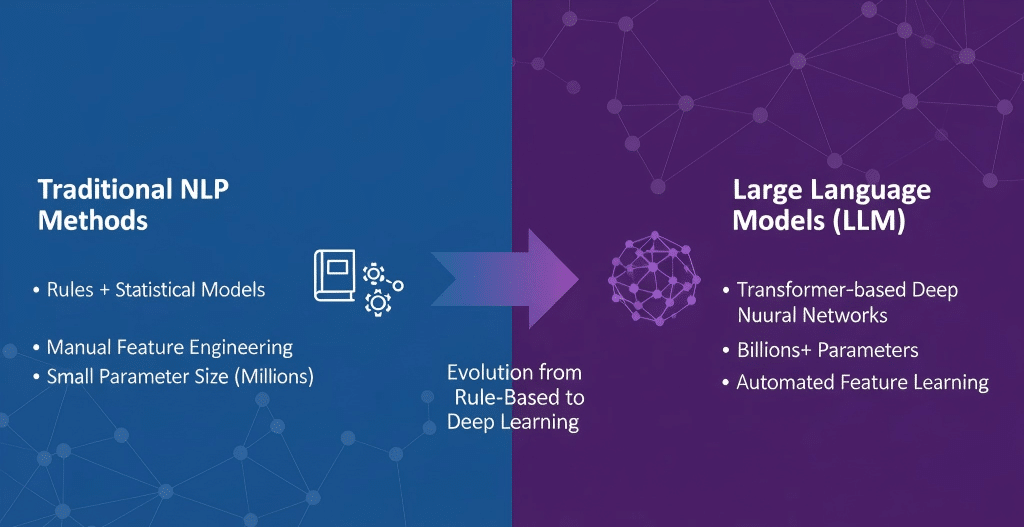

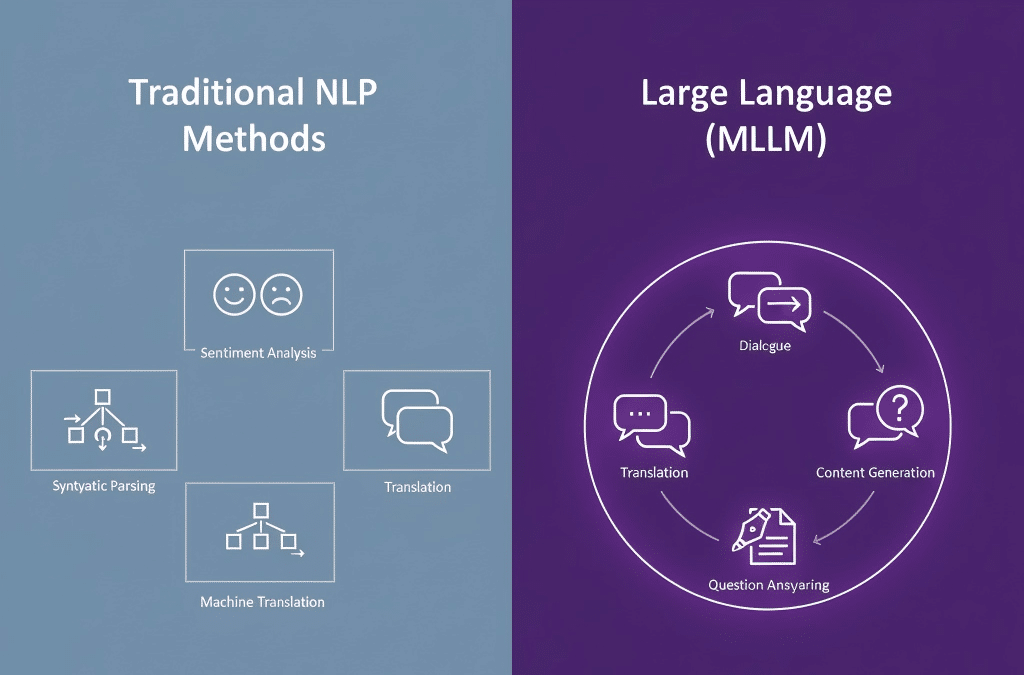

自然语言处理(NLP)是一门致力于使计算机理解、生成和处理人类语言的技术,涵盖任务包括语法解析、命名实体识别、情感分析和机器翻译等传统功能。NLP早期依赖规则和统计方法,其技术基础侧重于特征工程和浅层模型。相比之下,大型语言模型(LLM)如GPT系列,代表了基于海量数据和深度学习技术的创新突破,其核心是通过数十亿甚至数千亿参数的神经网络,自动学习语言的复杂结构和上下文关系。

| 维度 | NLP传统方法 | 大型语言模型(LLM) |

|---|---|---|

| 技术结构 | 规则+统计模型,特征明确,需要人工设计 | 基于Transformer的深度神经网络,端到端学习 |

| 参数规模 | 低至中等,受限于特征和模型复杂度 | 数十亿至数千亿,支持复杂语义和上下文理解 |

| 任务范围 | 具体任务分离,如语法分析、情感分类 | 统一模型,可执行多种语言任务 |

| 应用灵活性 | 受限,通常针对特定应用定制 | 高,支持生成、问答、翻译等多场景 |

从应用层面看,传统NLP应用多定位于具体且有限的任务,如语音识别系统、文本分类等。LLM则通过其强大的生成和理解能力,在智能助理、自动内容生成、复杂对话系统等领域展现出强大潜力。例如,GPT-4不仅精通语言生成,也支持跨领域知识整合,极大提升了智能客服和内容创作的效率。

| 指标 | 自然语言处理(NLP) | 大型语言模型(LLM) |

|---|---|---|

| 参数规模 | 数百万至数亿参数 | 数十亿乃至百亿以上参数 |

| 训练数据 | 专门标注数据集 | 大规模互联网语料及多模态数据 |

| 应用场景 | 文本分析、信息提取、规则基础对话 | 复杂理解、生成任务、多领域应用 |

LLM的发展推动了NLP的质的飞跃,其自动化学习和泛化能力弥补了传统NLP依赖规则和有限数据的缺陷。通过结合海量语料和强大计算资源,LLM显著提升了语言理解的深度和广度,带来了从工具型技术到智能型技术的转变。

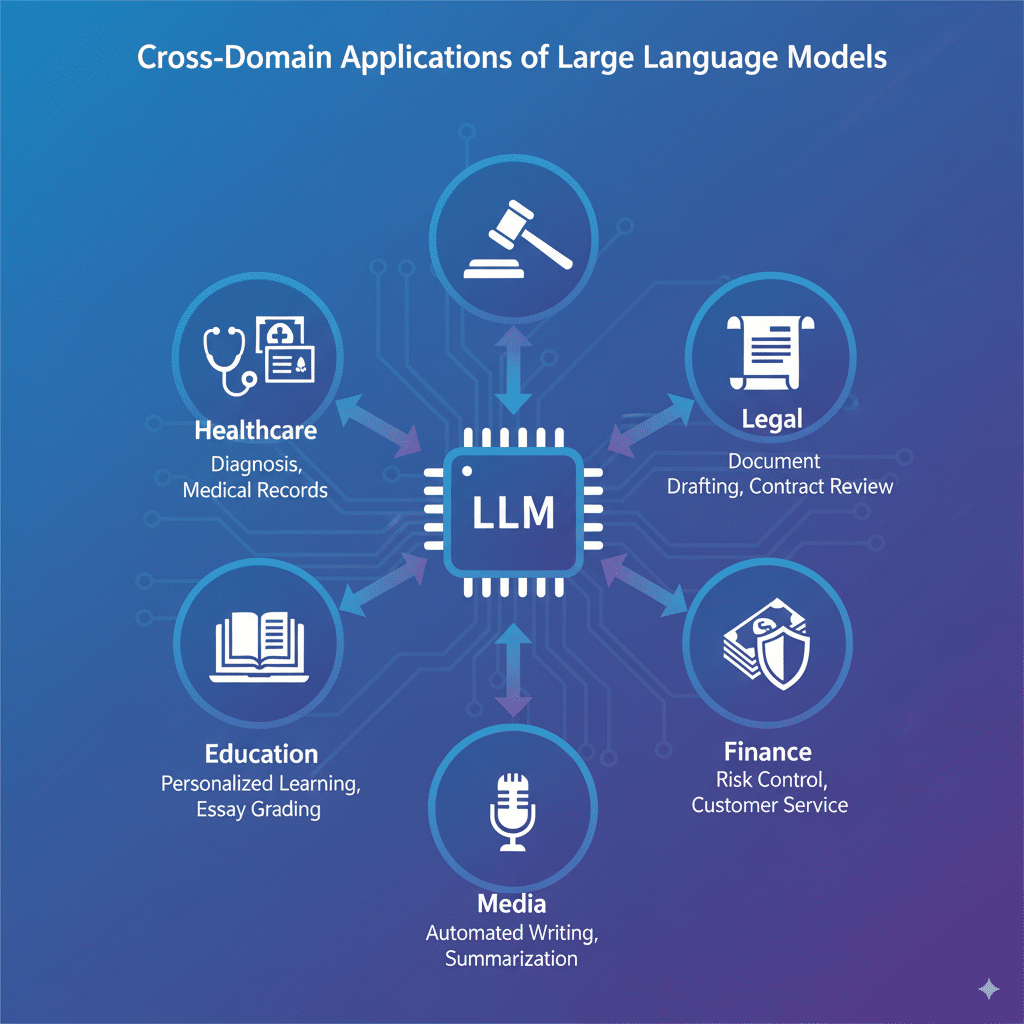

大型语言模型(LLM)正在医疗、法律、教育等多个关键领域展现出强大的变革力量,推动行业效率和服务质量的大幅提升。

医疗领域方面,LLM通过辅助诊断、病历自动生成和精准医学研究大幅提升了医生的工作效率。例如,某国际知名医疗机构引入的LLM辅助诊断系统,将医疗影像分析准确率提升了15%,病历文案时间缩短40%,业内评估显示该系统显著减少了误诊率。此类方案不仅优化医疗流程,还减少了人力资源压力。

在法律行业,LLM充当高效的法律助理,能够自动生成法律文件、合同审查以及案件研究。某领先法律科技公司的LLM产品应用后,律师文书工作时间减少30%,案件调研速度加快25%,并通过智能合同审核降低了合同漏洞风险,赢得众多法务专家的高度评价和用户的广泛认可。

教育领域的创新教学同样依赖LLM驱动。通过个性化学习内容推荐、自动批改作文以及实时答疑,大幅提升了教学效率与学生互动体验。一家在线教育平台数据显示,利用LLM辅助教学后,学生课程完成率提升20%,教师批改负担减少50%,教育质量显著提升,尤其在语言学习和写作训练中表现突出。

除上述主力行业,金融、零售、媒体等领域也纷纷引入LLM技术优化客户服务、风险控制及内容生成。金融行业依托LLM进行智能风控和客户咨询,媒体行业应用于自动新闻撰写与信息摘要,均实现了显著的业务流程革新。

当前,LLM跨领域应用虽然成效显著,但仍面临数据隐私、安全与模型偏见等挑战。各行业正持续推动算法优化和监管标准制定以确保安全可控。

综上,LLM已成为多个行业提升效能与服务质量的关键技术,现阶段表现出强劲的实用价值和广阔的未来潜力。未来,随着技术的成熟和应用深化,LLM将在更多领域造福用户,促进各行业智能化转型升级,实现更大社会价值。

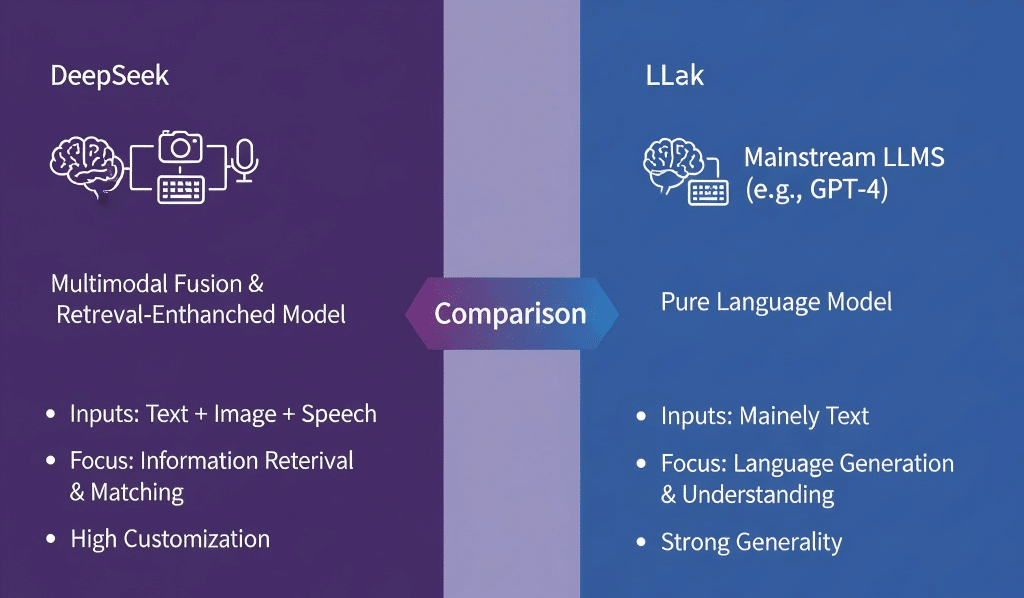

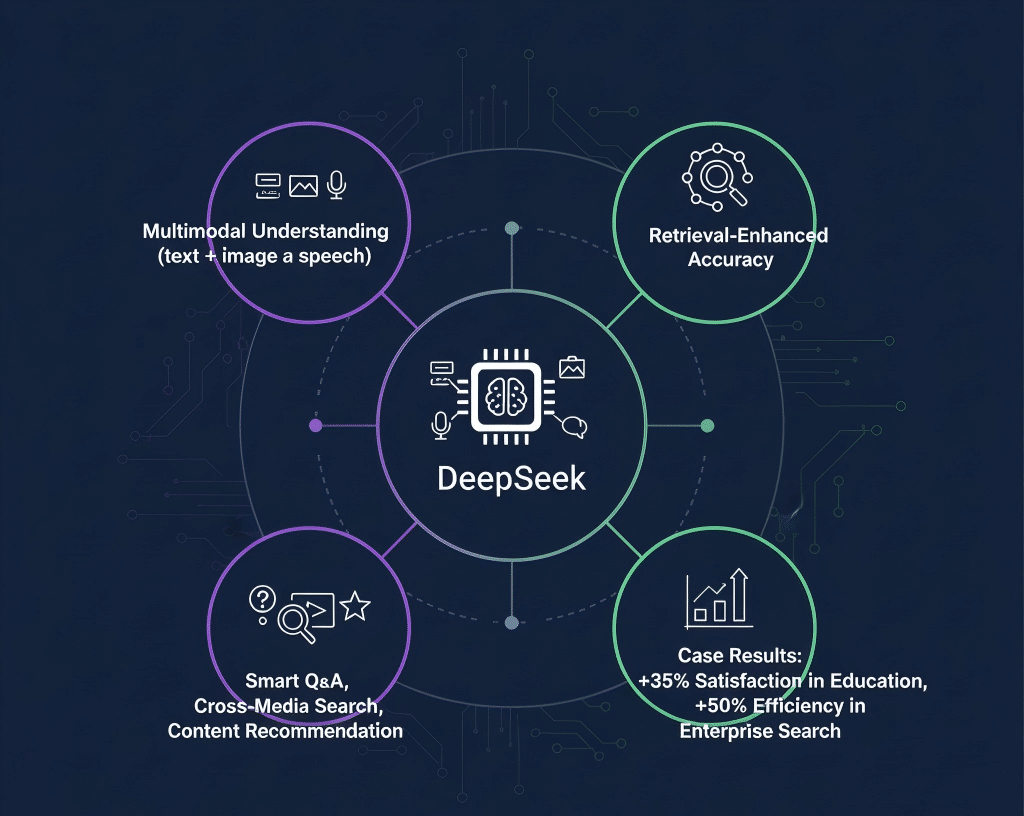

DeepSeek是一款基于深度学习的智能搜索平台,运用多模态数据处理和大规模预训练技术,旨在提升信息检索的精准度和效率。它集成了文本、图像、语音等多种数据形式的理解能力,以实现跨领域内容的深度匹配。

LLM(大型语言模型)定义强调模型通过大规模文本数据预训练,实现自然语言理解和生成能力。DeepSeek虽包含语言模型元素,但核心技术更多聚焦于多模态融合和检索优化,且其模型结构与典型的自动回归生成型LLM(如GPT系列)存在差异。

从官方技术资料看,DeepSeek不完全符合传统LLM的定义,它更像是一种结合了语言模型与检索增强的混合型智能系统。

| 特性 | DeepSeek | 主流LLM(例如GPT-4) |

|---|---|---|

| 模型类型 | 多模态融合,检索增强型 | 纯语言模型,生成型 |

| 输入数据类型 | 文本+图像+语音 | 主要文本 |

| 任务重点 | 信息检索与匹配 | 语言生成与理解 |

| 应用灵活度 | 定制化强,强调精准检索 | 通用性强,偏向语言交互 |

| 模型名称 | 参数规模 | 架构类型 | 核心应用场景 | 突出特点 |

|---|---|---|---|---|

| DeepSeek | 约数亿参数 | 混合架构 | 文本搜索与生成 | 优化的上下文理解与检索能力 |

总结:DeepSeek虽不完全是传统意义上的LLM,但结合大规模语言模型与多模态检索技术,形成独具优势的智能搜索体系。其精准的匹配能力和多样的应用场景,使其在实际应用中展现出超越传统LLM的竞争力,值得关注与深入研究。

近年来,大型语言模型(LLM)技术迎来了多项突破,奠定了未来发展的坚实基础。首先,多模态模型成为当下的技术热点,通过融合文本、图像、语音等多种数据形式,实现了跨模态理解与生成能力。以OpenAI的GPT-4为代表的多模态模型,不仅提升了信息的表达力,也拓展了智能应用的边界,推动了智能交互从单一文本向多感知融合的转变。

在模型优化方面,剪枝与蒸馏技术被广泛应用以降低模型复杂度和计算资源需求。通过剪枝精简参数,蒸馏将大模型知识迁移至轻量级模型,使得边缘设备也能高效运行LLM,显著拓宽了应用场景。最新研究显示,适当的剪枝和蒸馏策略可在不牺牲准确率的前提下减少30%-50%的计算资源消耗。

隐私保护成为LLM发展的关键问题之一。技术创新如联邦学习、多方安全计算等正被引入到LLM训练和推理中,确保用户数据不被暴露。与此同时,算力需求驱动下的异构计算架构、定制化芯片设计不断提升模型运行效率,为大规模推广提供了技术支撑。

展望未来,LLM技术将进入更加智能与高效的阶段。新兴方向包括持续学习能力的增强以适应动态环境,绿色AI推动能耗降低,以及更加广泛的行业定制应用。例如,医学、法律和金融等领域将通过个性化定制的LLM实现知识自动化与决策辅助,极大提升专业效率。

| 模型名称 | 参数规模 | 训练数据量 | 应用场景 | 性能评价指标 |

|---|---|---|---|---|

| ChatGPT | 1750亿 | 数千亿词 | 多任务对话、写作 | 高准确率,响应速度快 |

| 指标名称 | 重点内容 |

|---|---|

| 模型压缩 | 提高模型运行效率,降低计算资源消耗 |

| 案例名称 | 应用效果 | 技术亮点 |

|---|---|---|

| 医疗诊断辅助 | 提高诊断准确率25% | 结合多模态数据融合技术 |

随着技术的成熟与应用场景的拓展,LLM必将成为推动智能社会的重要引擎。掌握其核心原理和最新趋势,能助你在未来人工智能浪潮中抢占先机。

Q1: DeepSeek是LLM吗?

DeepSeek并非传统意义上的大型语言模型(LLM),它是结合了语言模型与多模态检索技术的混合型智能搜索平台,强调多模态数据的融合和精准信息检索。

Q2: NLP和LLM有什么区别?

NLP是广义上的自然语言处理技术,涵盖规则和统计方法等传统技术,而LLM是基于深度学习的海量参数模型,具备强大的语义理解和生成能力,属于NLP的先进分支。

Q3: LLM的本质是什么?

LLM本质是通过大规模参数的神经网络模型,利用海量文本数据进行自监督训练,自动学习语言规律,实现自然语言的深层次理解与生成。

Q4: 什么是LLM幻觉?

LLM幻觉指模型生成的内容出现逻辑、事实或语义上的错误,包括误报、断章取义和虚构事实,影响输出的准确性和可信度。

说明:以下内容并非原创,由开发者提供,纯免费帮忙,不为产品背书。

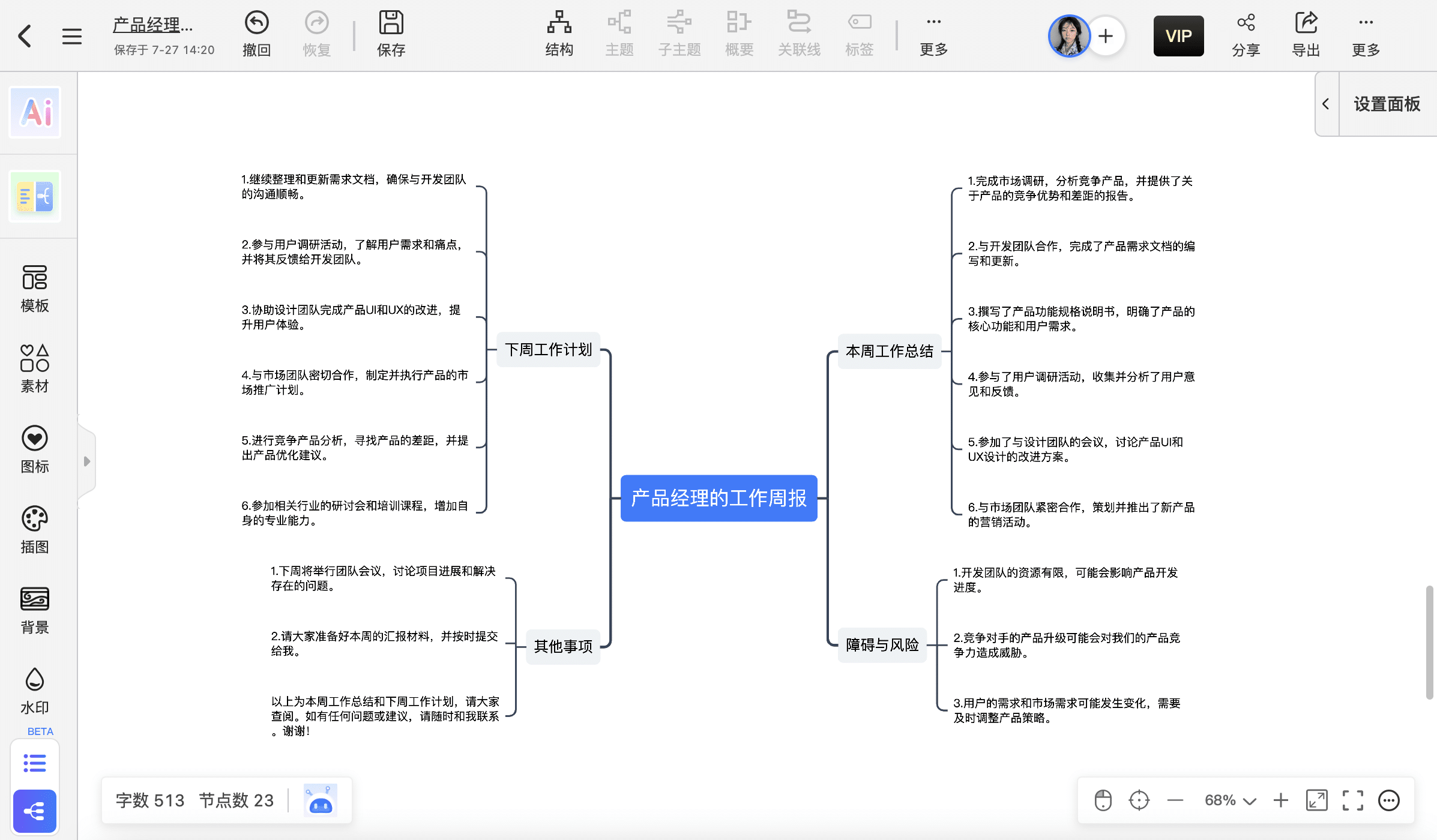

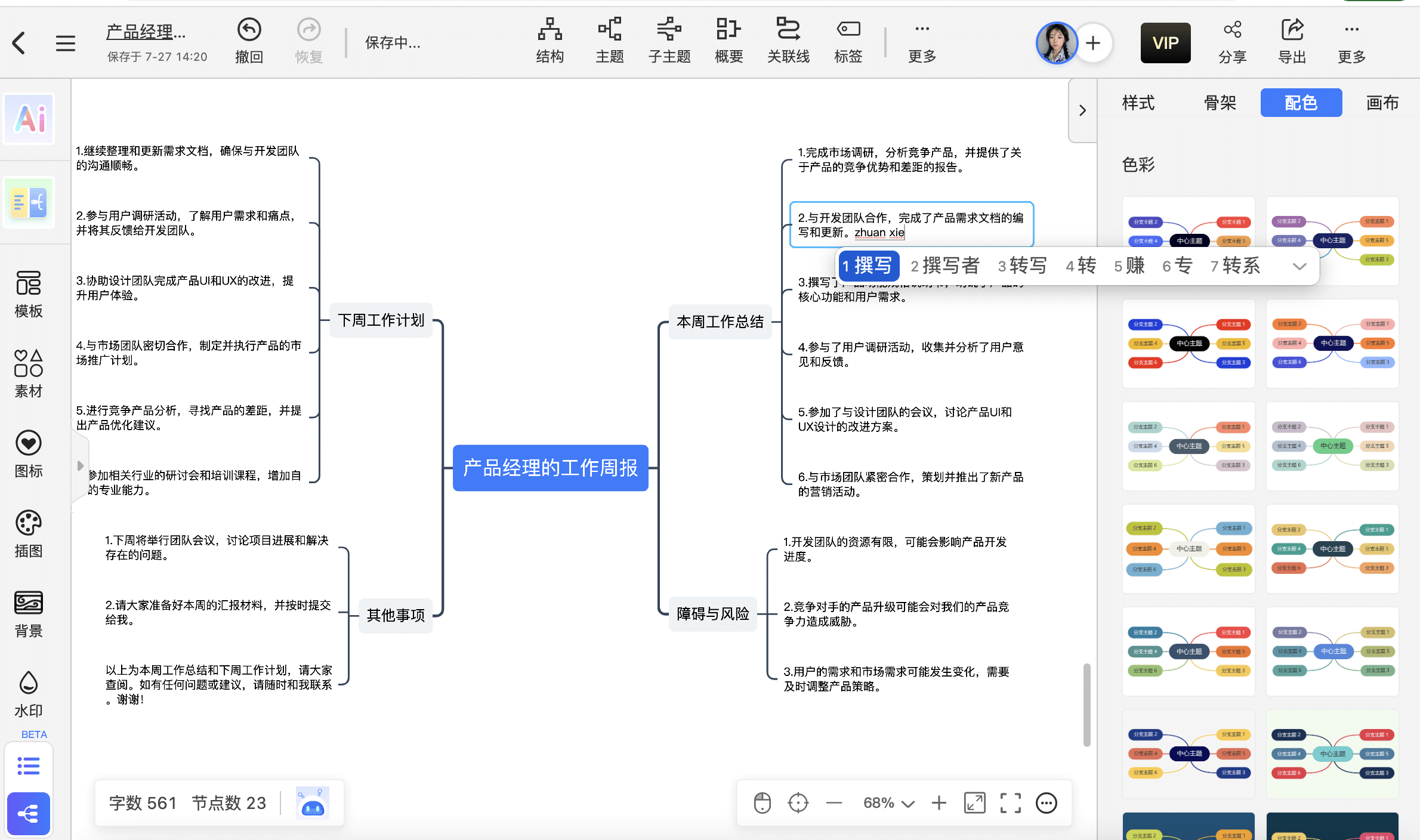

据调查显示,使用思维导图的产品经理更有可能在职场上脱颖而出,成功率高达80%!

在这个信息爆炸的时代,如何高效地组织、整理、挖掘和应用知识,成为每一位产品经理所面临的挑战。

面对这一挑战,思维导图成为了大厂经理们高薪的秘密武器。

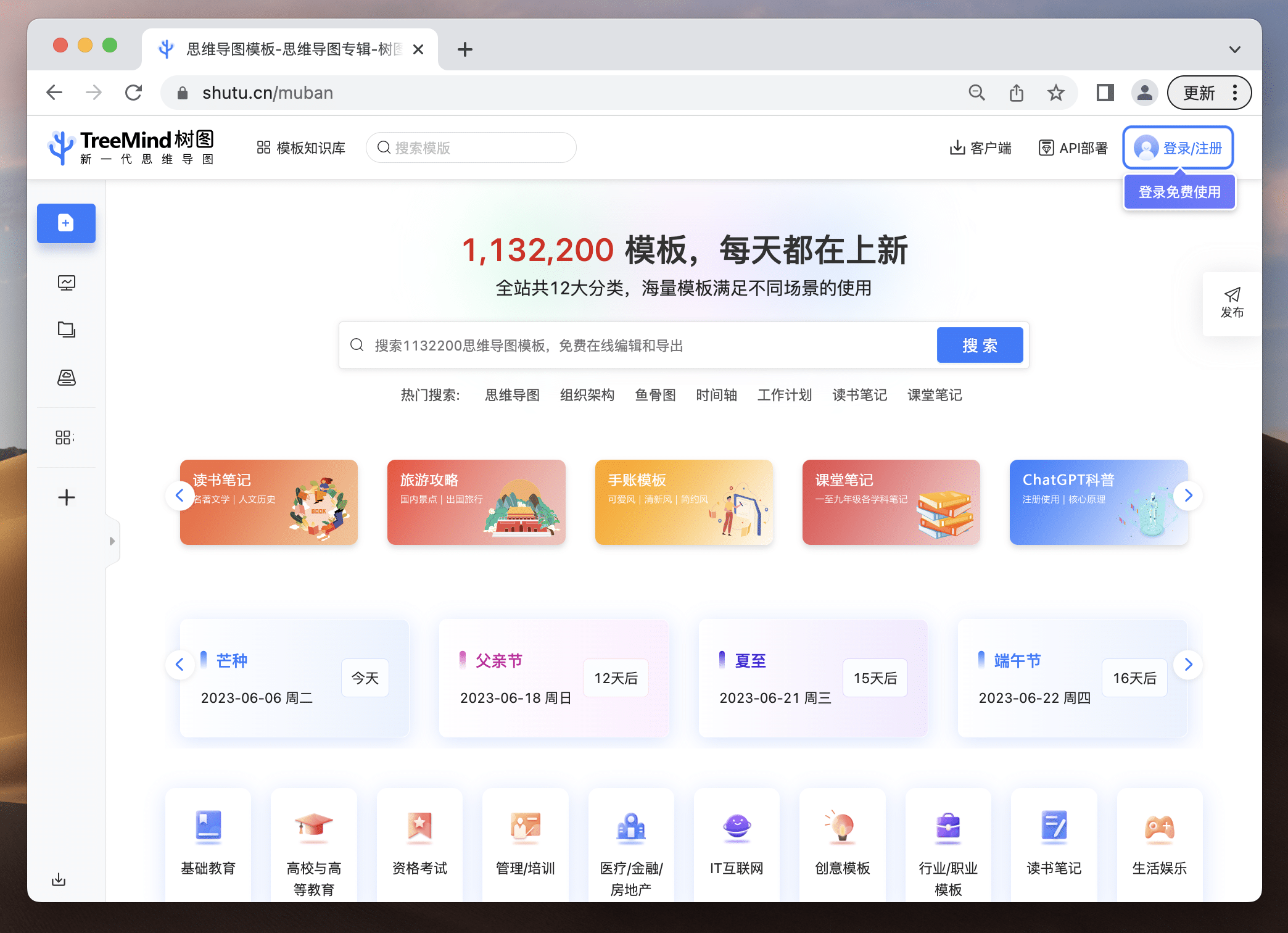

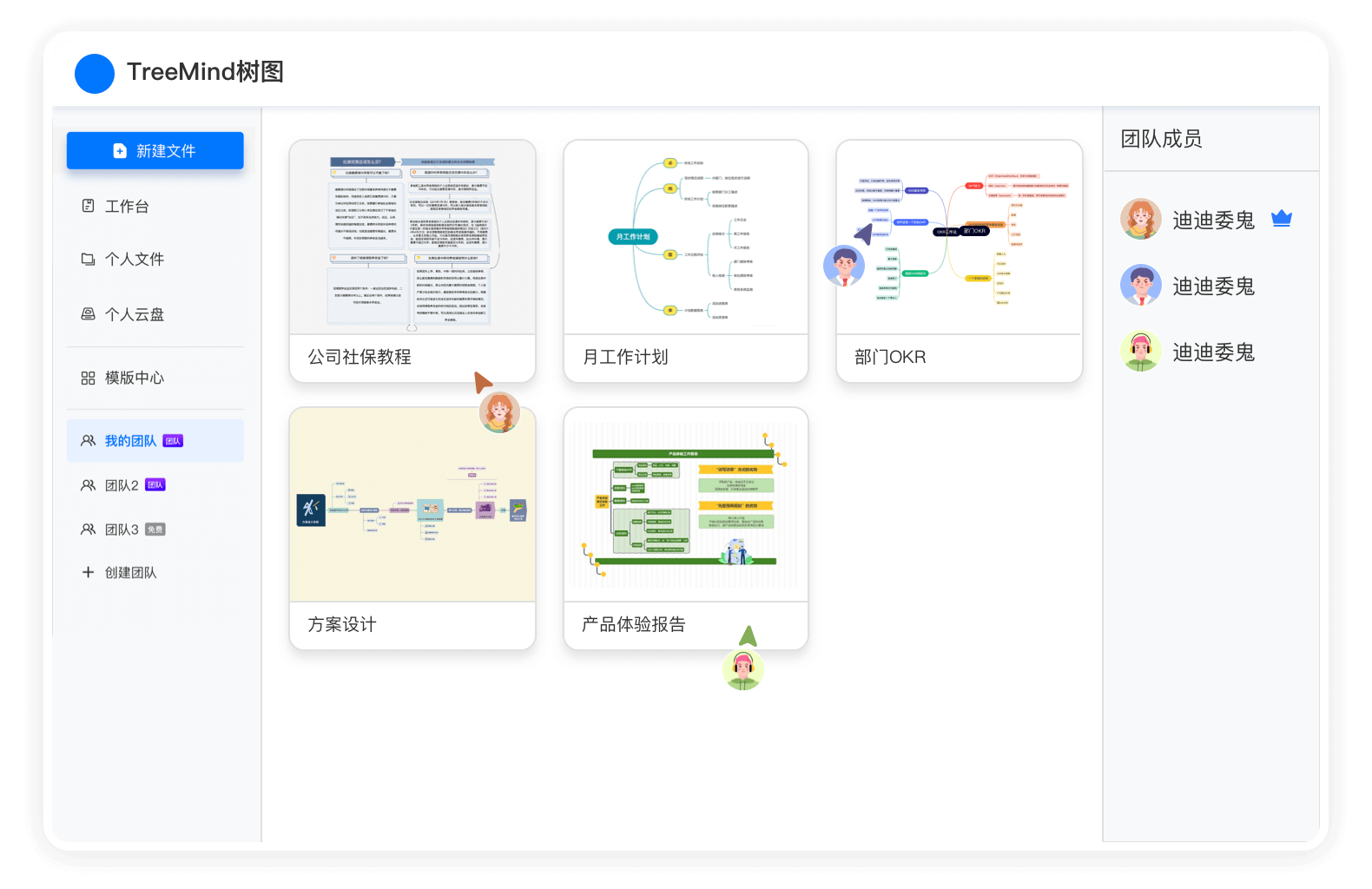

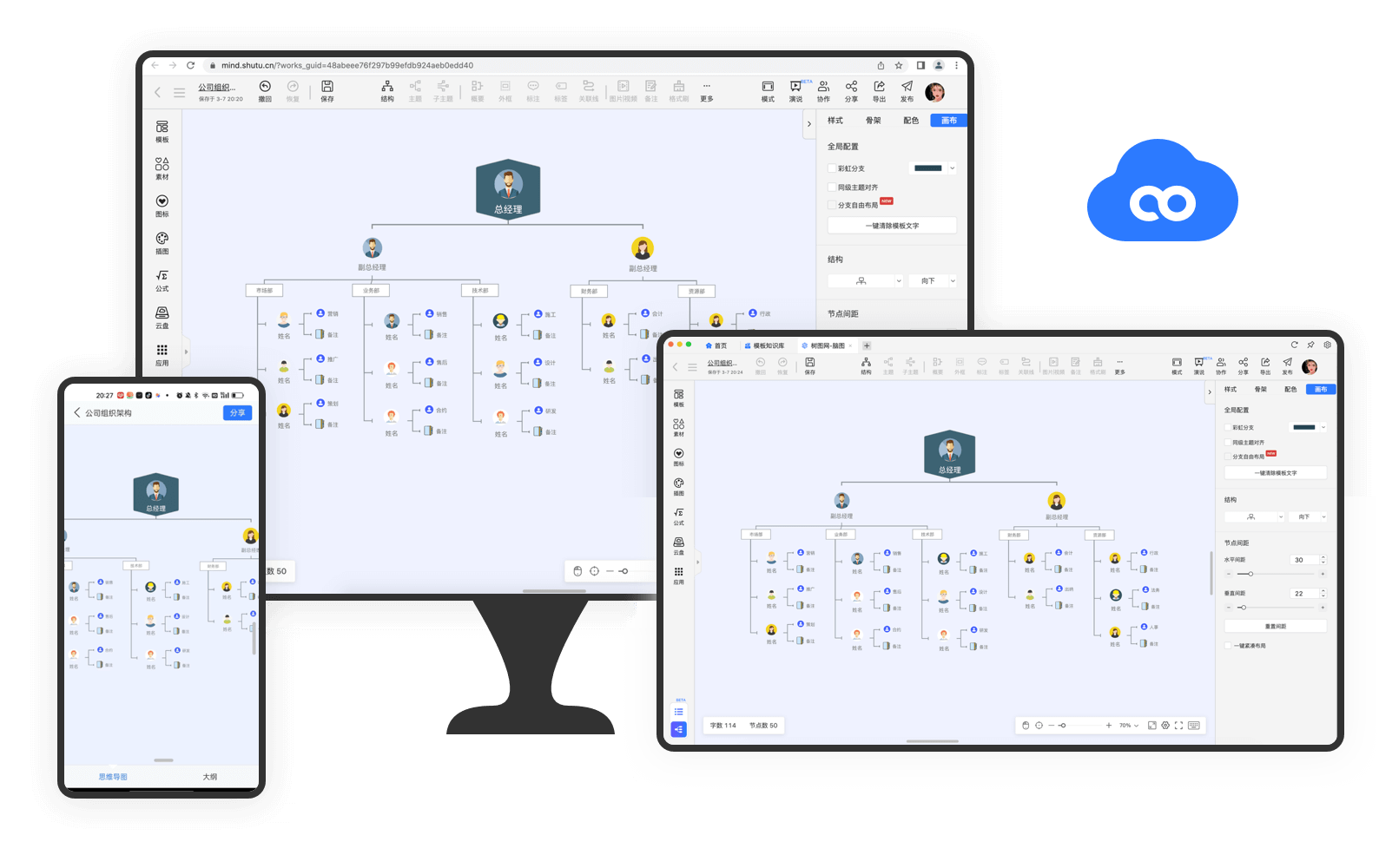

而TreeMind树图就是思维导图中的加速器,搭载媲美GPT的人工智能大模型,AI一句话即可生成逻辑清晰、层级分明的思维导图,让产品经理的工作更轻松。

作为首批「AIGC+思维导图」平台,TreeMind树图一句话即可生成详实的思维导图,开启了AI生成思维导图新时代,能够快速提升你的学习和工作效率。还有上百万的模板,满足各行各业、不同细分领域需求,是真正思维导图届的“百科全书”。

戳这里体验:https://shutu.cn/?from=cpjldrgznxxk

……

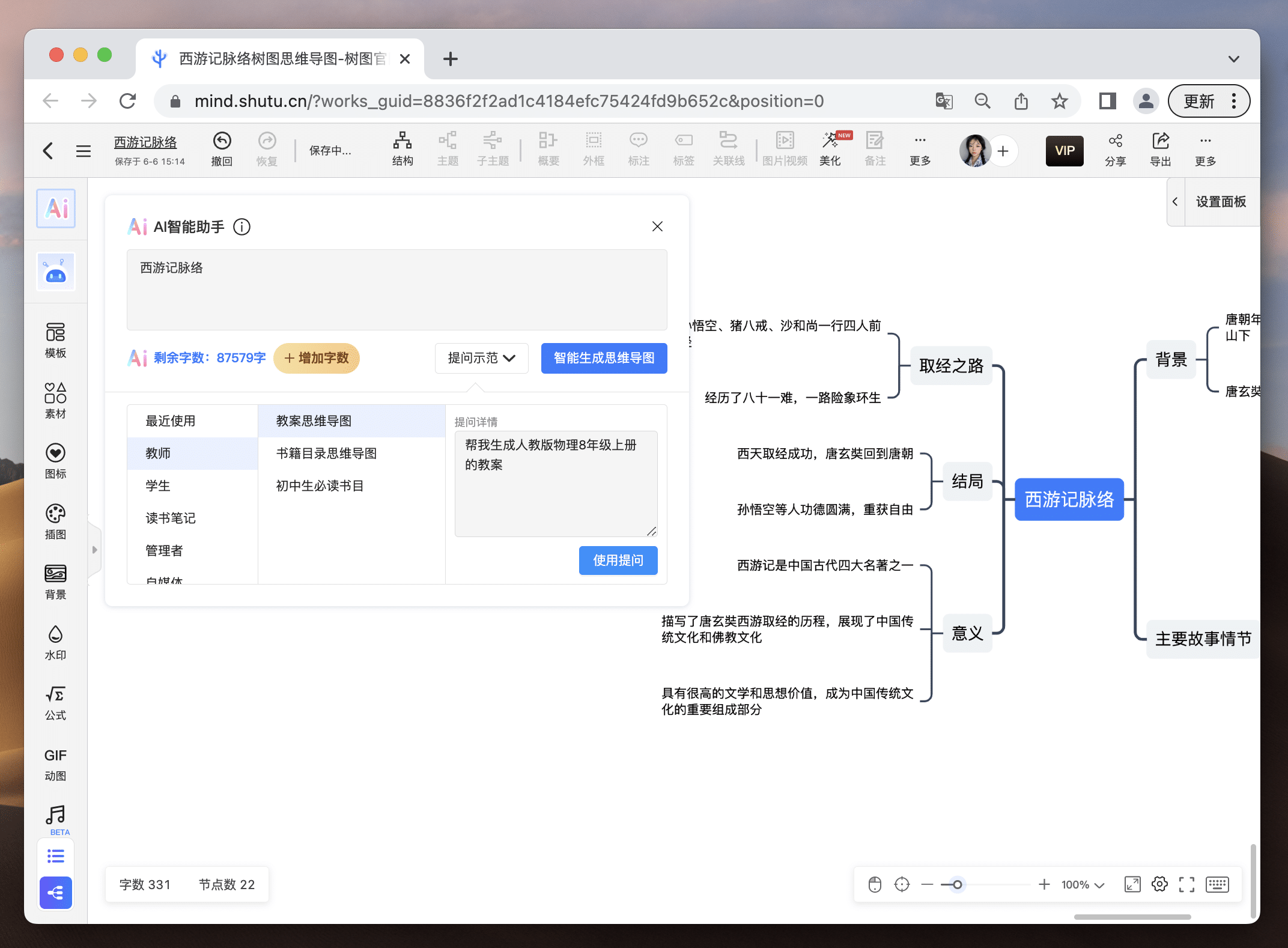

从未做过思维导图的小白不知从哪开始?不要慌!提出需求,结合当下最火的ChatGPT,树图AI直接帮你一键生成定制化思维导图,并且还支持随意修改,新用户注册就送2000字的AI字数体验!免费的羊毛,你还不薅?

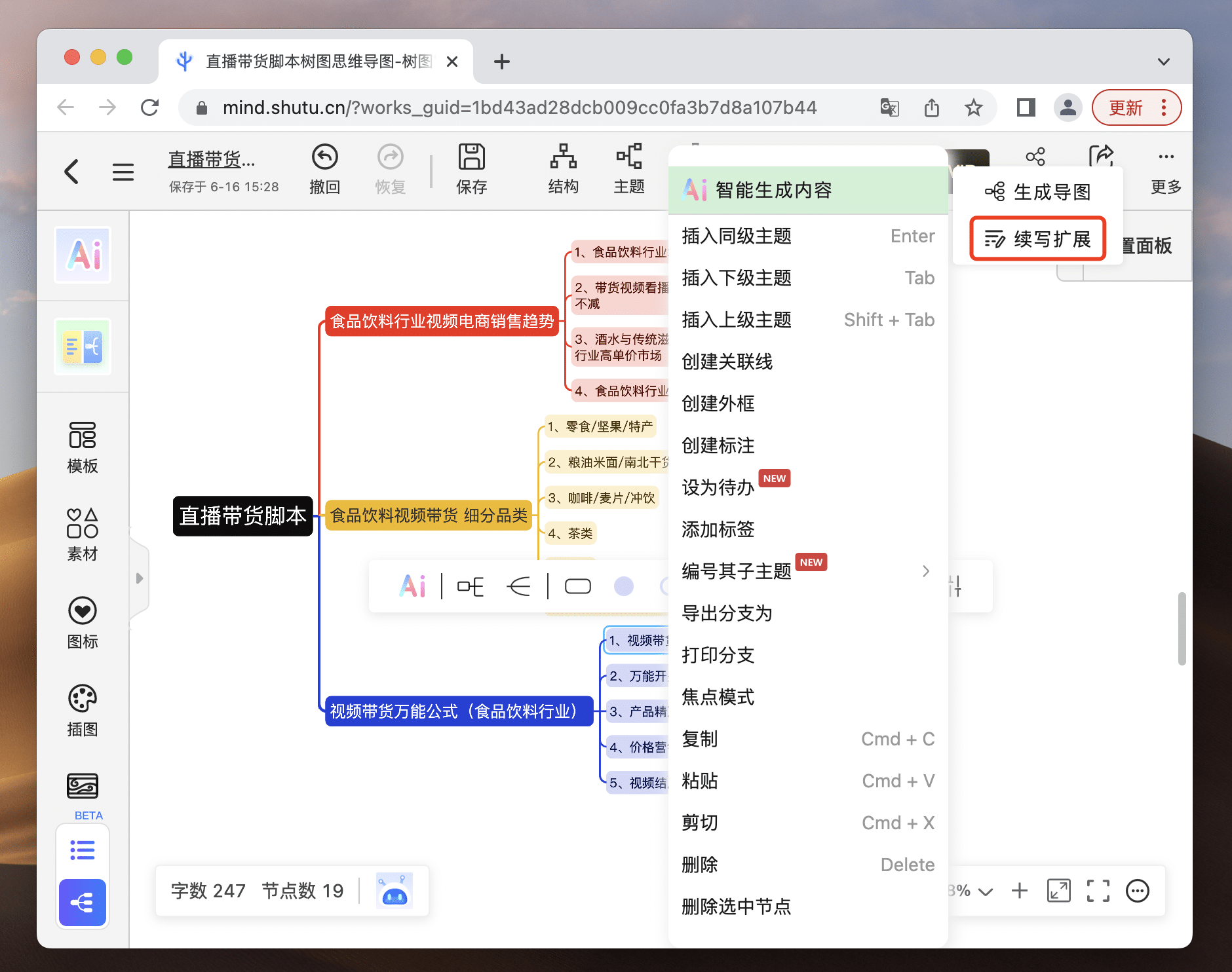

AI思维导图智能库功能齐全强大,不管你是工作汇报还是提炼读书笔记,就算是当下最火的视频脚本解析,它都能帮你准确生成,大大提高你的生活和工作效率!并且智能库还会不断更新,不会面临重复或内容过时的局面。生成的思维导图不限节点增删,哪里需要改哪里!

自己做的思维导图没有灵感?你还能让AI参考你的思路继续扩写,拒绝灵感枯竭!让你站在巨人的肩膀开阔眼界,让你的思维和灵感立刻涌现。

无论是需求整理、产品规划、市场分析、或者是团队沟通,只要涉及到信息的整理和传递,TreeMind树图都能为您提供极大的帮助。

将近150万+导图模板,每天都在上新!包含多达829个精选专辑、共计123个模板品类、覆盖12种行业类型,帮你释放创意无限潜力!无论你要做什么类型的思维导图,在TreeMind树图模版库99%能找到!直接在大佬的思维导图上进行修改,帮你开阔思路,成为思维导图高手。

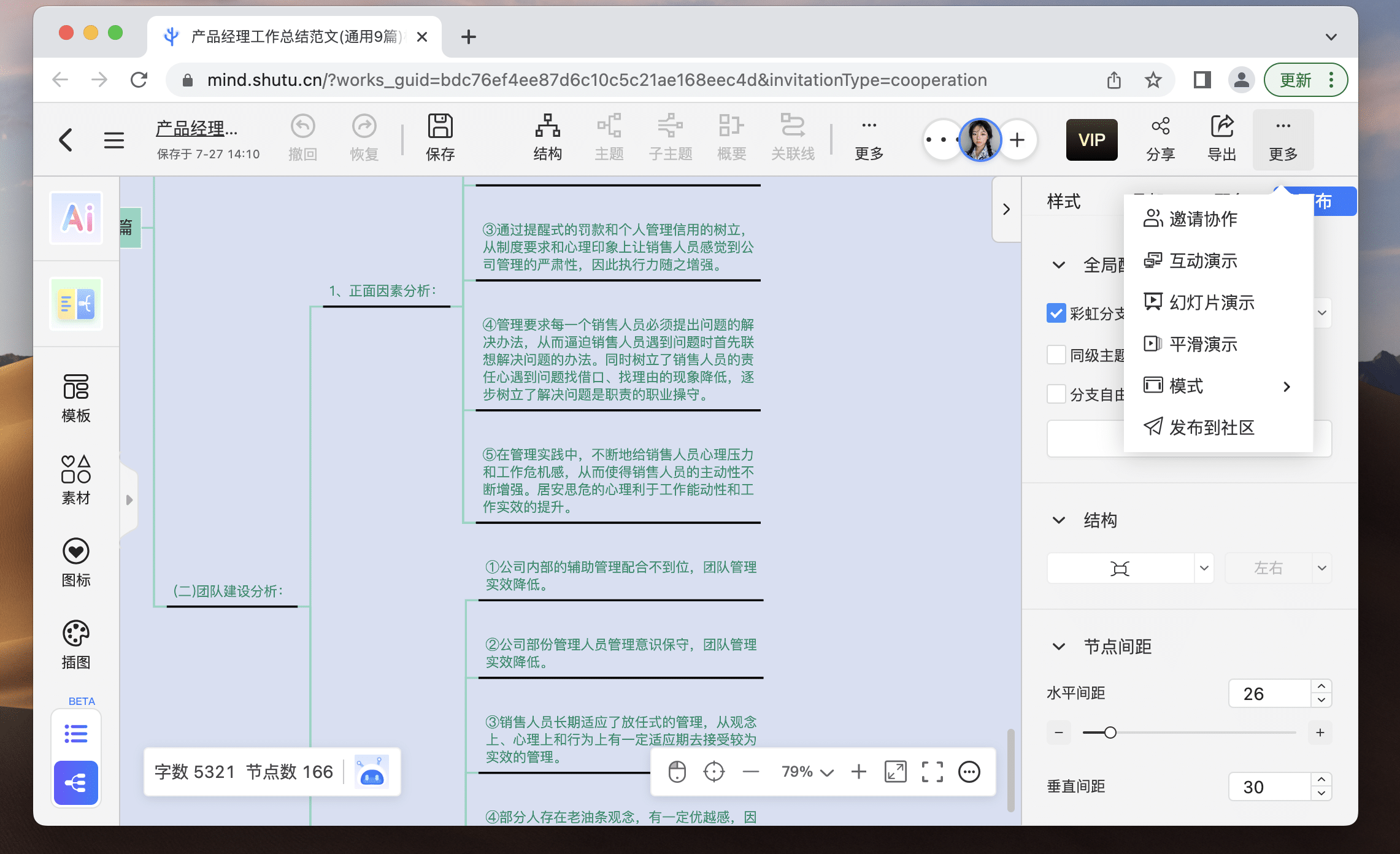

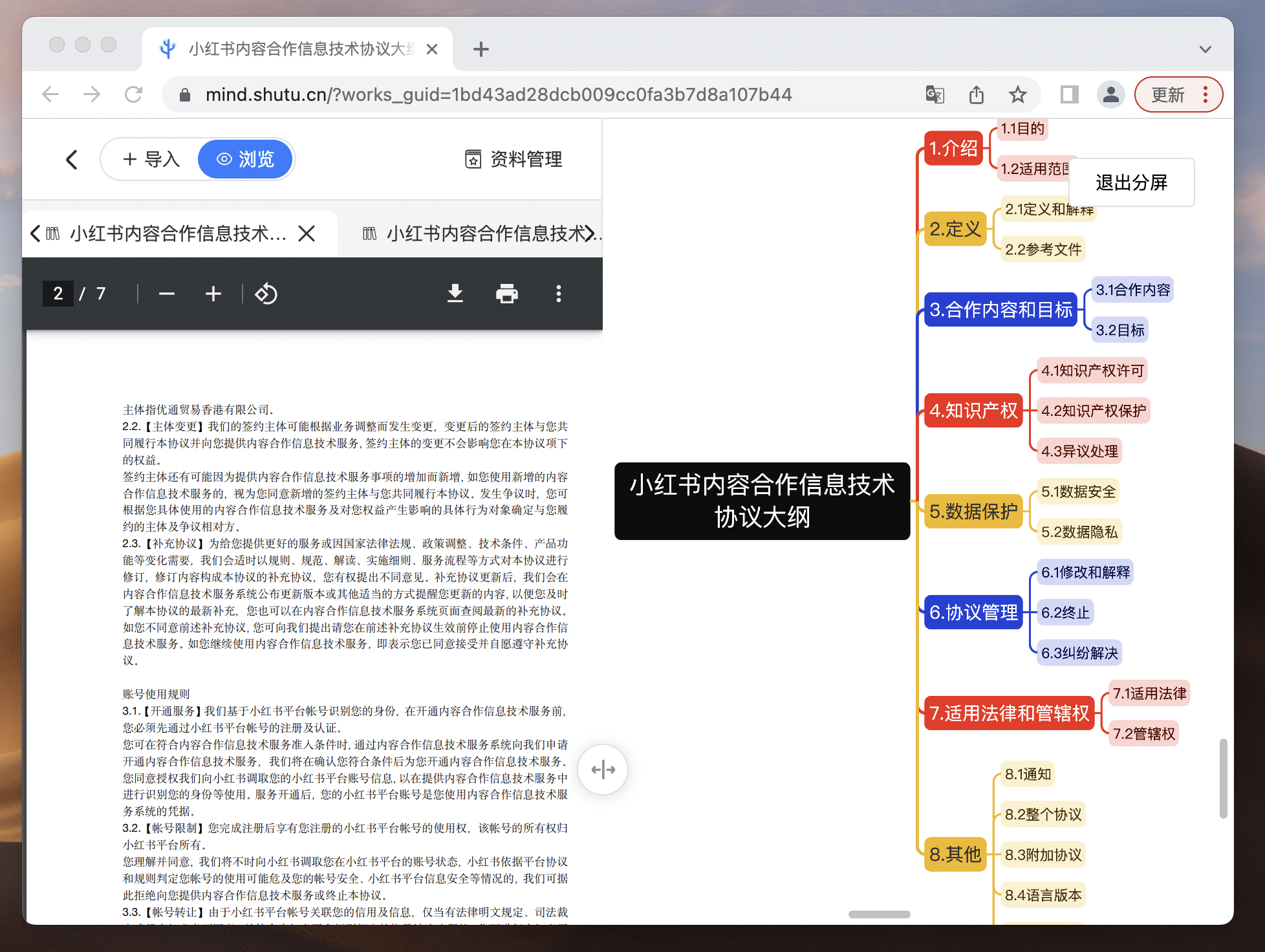

在绘制复杂思维导图时,参考大量资料是家常便饭,但频繁跳转窗口查看资料与编辑思维导图的传统方式实在低效。

一屏两用让你的读写模式so easy!一边阅读文件,一边制作思维导图,学习效果翻倍!资料上传支持3种导入方式:文件导入、粘贴导入、网址导入,支持PDF、Word、Txt三种文件格式,无需转换,直接参考!更棒的是,历史资料库自动备份,让你不再担心文件丢失!此外,我们还增加了窗口大小调节功能,随心调整界面,提供更舒适的学习环境!二者衔接,让你的导图绘制更加丝滑!

无论是特殊时期在家办公,还是多人协作完成一个方案/作业,都需要很方便地将自己的创作内容分享给同事,时不时也需要来一场多人头脑风暴,多人在线分工共同完成一个事情。传统的软件只能每人单独完成一份文件,最后将多人文件合并在一起,然后统一修改。

目前市面上的大多数思维导图软件,都需要下载安装客户端才能使用,要么占用电脑磁盘空间,要么就是浪费手机内存,最重要的是偶尔也会碰到盗版软件和流氓软件。TreeMind树图是一款在线思维导图工具,打开浏览器访问网站即可快速创建思维导图,让自己的灵感快速穿梭在思维导图的一个个节点上,学习力和生产力拉满。

同时TreeMind树图实现了「实时保存,内容可多平台文件同步」,再也不用担心忘记保存、软件崩溃导致内容丢失,让自己专注于内容创作和灵感爆发,不受其他干扰~在浏览器,客户端,手机端都可以修改和浏览文件。

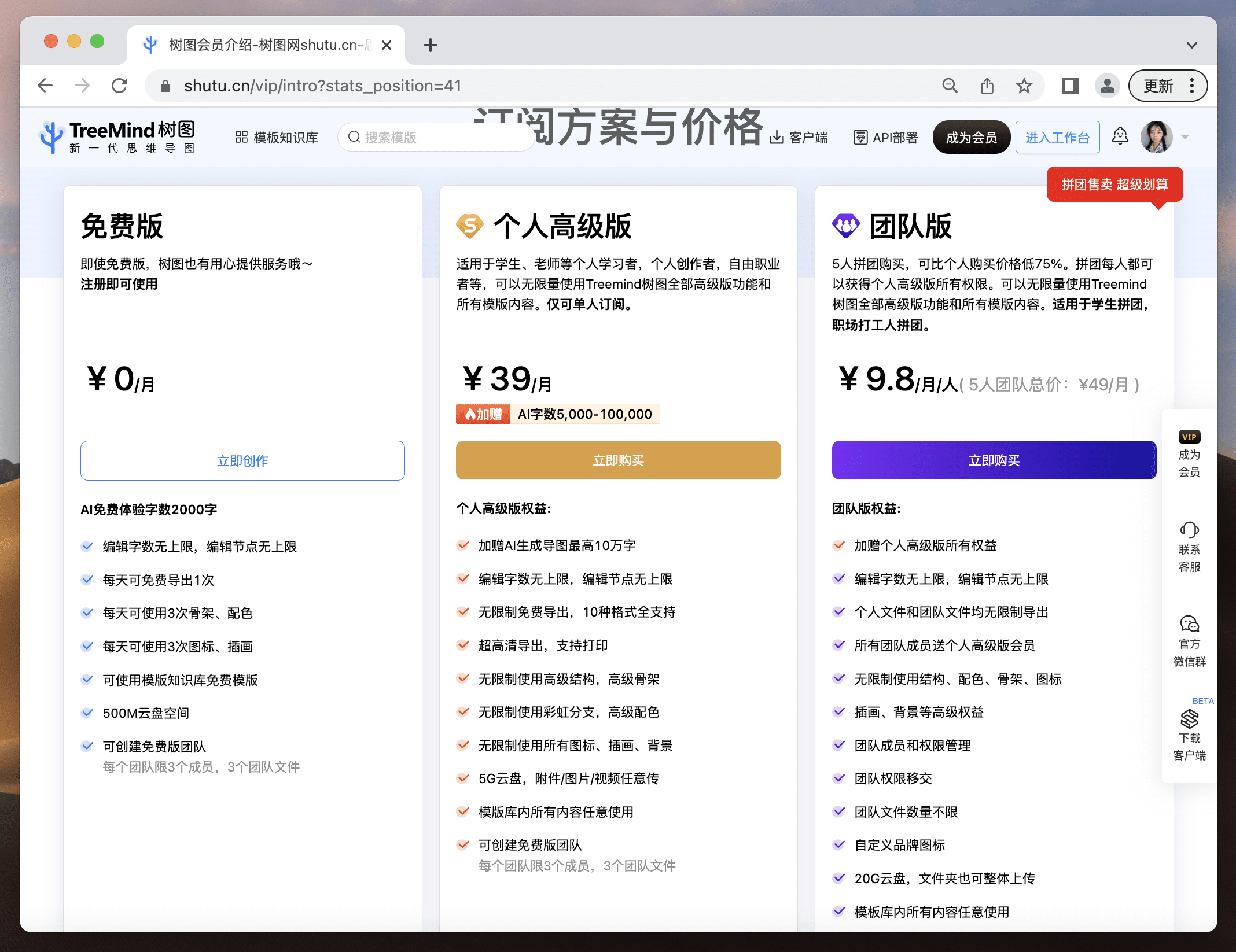

TreeMind树图的大部分权益都可以免费使用,对于刚接触思维导图的新手小白,TreeMind树图也提供了每日免费导出1次➕AI字数2000字的至尊体验;开通会员后更是可以解锁更多权益,成为思维导图届的大神!同事们一起拼团购买,还能享受到团队优惠价。

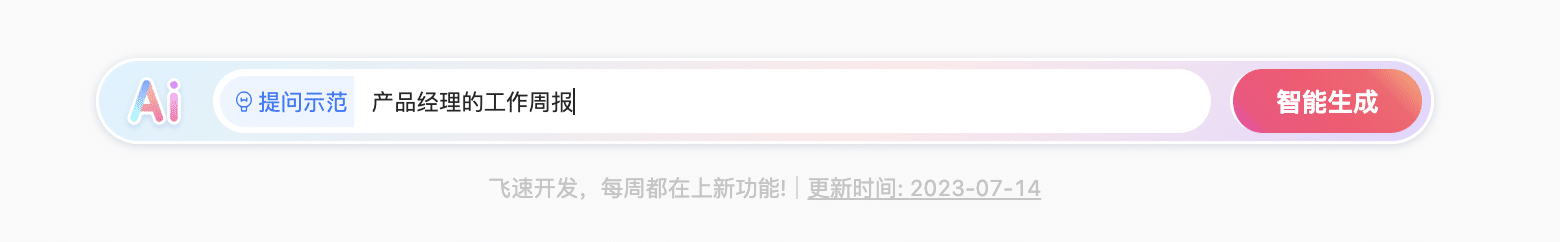

打开网站在文字框内输入你的需求,AI就会自动生成一份相关的定制思维导图。

比如,我在这里输入:

让它以此帮我生成工作周报!只要输入主题,然后点击智能生成即可。结果如下图所示:

在工作台,选择你要创建的导图类型,就可以新建绘制你自己的导图啦!

比如:你想定制自己的工作周报,只要选择合适的导图框架就可以在节点上自由绘制,还可以在模版库现有的模版上免费修改。结果如下图所示:

惊天好消息!TreeMind树图目前也上线了终身会员,每天前20名购买的粉丝可以享受立减200元,终身VIP仅需早鸟价399元!倒计时5天!欲购从速!

看完后是不是被TreeMind树图出色的功能和贴心的服务惊艳到了,想要提高工作效率的产品经理们可以去试试,它的会员价格可以说是白菜价了。一个会员可以多个平台通用,非常划算,强烈安利大家入手!

无需下载点击即用:https://shutu.cn/?from=cpjldrgznxxk

您想要了解的有关营销AI内容生成应用程序的所有信息

要创建有效的机器学习工具箱,您实际上仅需要以下三个基本工具:Feature Store、Model Store、Evaluation Store

到2022年,出货的智能手机中80%将具有终端设备上AI功能,高于2017年的10%

我们将更深入地探讨数据科学生命周期本身的七个步骤,以及非技术项目负责人应理解的过程方面